Report

💡 Active projects and challenges as of 28.02.2026 19:41.

Hide text CSV Data Package Print

#automatisierung-berichte

Automatisierung von Berichten

hackday-automatisierung-berichte

Daten

Die Daten werden auf Google Spreadsheet gepflegt.

Datenimport

import getBEData

getBEData.getChart1()

getBEData.getTable1()

#datafyingbaern

Datafying Bärn

Wer hat wann und wo in Bern gewohnt? Daten in den Adressbüchern der Stadt Bern (1900-1945) strukturieren.

Was?

Die Universitätsbibliothek Bern hat in Zusammenarbeit mit dem Stadtarchiv Bern die Adressbücher der Stadt Bern vollständig digitalisiert. Hier sind alle Einwohner, Gewerbe und Einrichtungen mit Adressen im alten Stadt-Bern verzeichnet. Wir beschränken uns in der Challenge auf die Einwohnerverzeichnisse der Jahrgänge 1900-1945 - diese verfügen zudem über (sehr interessante :) Berufsangaben der EinwohnerInnen.

Diese Angaben sollen in eine strukturierte Form überführt werden, damit sie für Analysen und weitere Anwendungen nutzbar werden. Denkbar ist ein einfaches Format wie z.B. CSV oder JSON, das die Daten Name, Vorname, Beruf, (Titel/Anrede), (Quartier), Strasse, Hausnummer, (Telefonnummer) enthält.

Wie sieht so ein digitalisiertes Adressbuch aus? Hier ist ein Beispiel. Die Adressbücher sind nicht nur so kapitelweise strukturiert zugänglich, sondern Bildateien, Original-OCR-Dateien, TXT-Dateien und PDFs (je Kapitel) sind über Schnittstellen verfügbar.

Und wo ist das Problem?

Die Datenelemente der Personen sind in der Regel mit Kommata getrennt, die Anzahl der Datenelemente kann jedoch variieren. Es werden viele Abkürzungen verwendet und es gibt dann und wann OCR-Fehler. Neben Personen tauchen auch Einrichtungen auf.

Materialien

📦 File: Infomaterial (PDF) zu Datenzugängen, Schnittstellen & Formaten

📦 File: Tabelle (CSV) mit IDs der Einwohnerverzeichnisse je Jahrgang

📦 Aktuelles amtliches Verzeichnis der Gebäudeadressen: Zur Kontrolle der OCR-erfassten und strukturierten Adressen, Hinweis: Spalte COM_FOSNR nach 351 (BFS-Gemeindenummer für Bern) filtern

📦 File: Familiennamenbuch der Schweiz (CSV) [Familiennamenbuch online] als Kontrollvokabular

Ausgangsdaten: Berner Adressbücher

- alle Bände (Jahrgänge) der Berner Adressbücher auf einen Blick auf e-rara

- Beispiel Seite JPEG, max. Auflösung

- Beispiel Seite ALTO-XML, original OCR-Datei

- Beispiel Seite TXT, Inhalt = original OCR-Daten

- Beispiel Kapitel Einwohnerverzeichnis, Textlayer = original OCR-Daten

Quellen für die Auflösung von Abkürzungen, historische Wörterbücher, topografische Informationen

- Sammlung von Thomas im Slack-Channel #datafying_bärn

Bern Address Book

Setup

$ git clone https://github.com/brawer/bern-addresses.git

$ cd bern-addresses

$ python3 -m venv venv

$ venv/bin/pip3 install -r requirements.txt

$ venv/bin/python3 src/fetch.py

Daten retten Leben

Ausbreitung einer Schadstoffwolke

Challenge

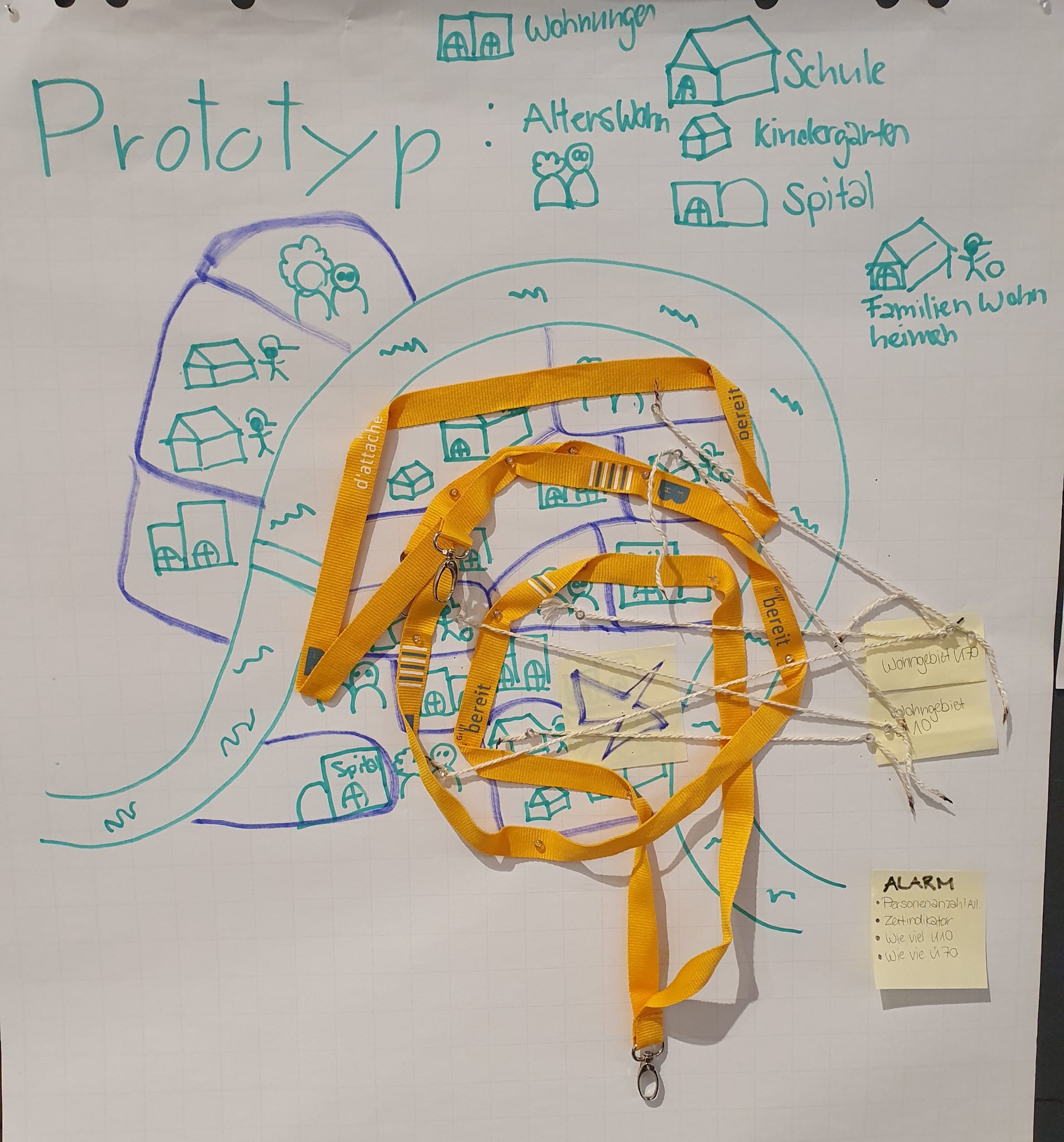

Gemeinsam mit dem Challenger Owner haben wir seine genauen Anforderungen ermittelt. Wir haben ein Flipchart erstellt und unsere Visionen visualisiert. Tatkräftig sind wir aktuell an der Umsetzung des Prototyps und an der Entwicklung einer Software Lösung. Dabei wurden uns neue Möglichkeiten aufgezeigt, die unser Team hoch motiviert haben. Mit Blaulicht schreiten wird in diesem Projekt an.

Analyse von Raumdaten für Schutz & Rettung

Teilnehmer

- Patricia

- Simon

- Mätthu

- Housi

- Domi

Ziel

- Räumliche Daten auswerten. Gegeben ist eine Wolke welche einen Raum abdeckt(Polygon): Der Nutzer soll darüber informiert werden welche Regeln und Points of Interest ausgelöst werden.

- Regeln: Regel basierend auf verschiedenen Attributen der darinliegenden Gebäude

- Simulation Prognose: Verschiedene Gebiete mit Zeitachse darstellen.

Anleitung

Fall: Ein Alarm für eine Schadstoffwolke wurde ausgelöst und in der Notrufzentrale gemeldet.

Hier sind die Schritte zur Handlung:

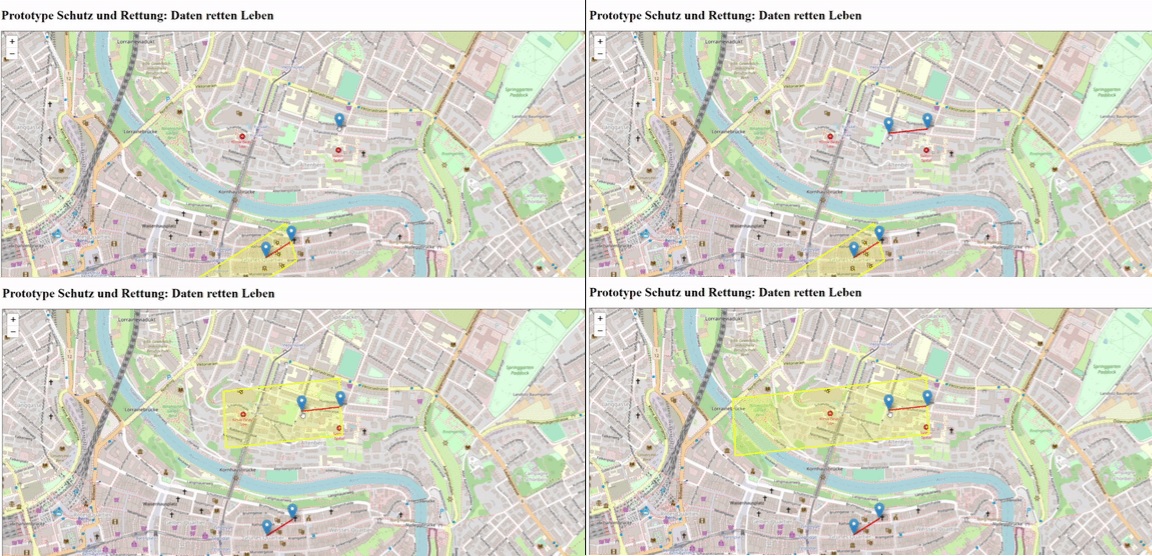

Schritt 1: Bitte öffnen Sie den folgenden Link: https://dominicschweizer.github.io/data-hackdays-23-daten-retten-leben/prototype-2/

Schritt 2: Durch einen Klick auf der Karte wird der betroffene Ort markiert, an dem der Alarm gemeldet wurde.

Schritt 3: Mit einem zweiten Klick werden die Windrichtung (Abstand zum Ereignispunkt) sowie die Geschwindigkeit der Schadstoffwolke markiert.

Innerhalb von Sekunden wird angezeigt, wie viele Personen und insbesondere wie viele besonders schutzbedürftige Personen potenziell betroffen sind. Die Schadstoffwolke breitet sich aus und im Verlauf einer Stunde erreicht sie weitere Personen.

Nun können Sie einen Evakuierungsplan erstellen und Einsatzkräfte mobilisieren. Vergessen Sie nicht : Don't Panic!

News

Samstag, 14:00 Uhr Prototyp vollendet

Das Team hat nun den Prototypen erfolgreich abgeschlossen. Unser nächster Schritt besteht darin, ihn an die Endbenutzer und die Teilnehmer des Data Hackday weiterzugeben, um sie zu befähigen. Wir sind überaus glücklich und zufrieden mit den zwei Tagen harter Arbeit. Es hat uns wirklich im Team Spass gemacht, und wir haben etwas Gutes erreicht.

Die Anleitung wird zu einem späteren Zeitpunkt auf dieser Seite veröffentlicht.

Wer schon mal "Spienzlä" möchte, hier findet Ihr den offiziellen Link: https://dominicschweizer.github.io/data-hackdays-23-daten-retten-leben/prototype-2/

Samstag, 11:30 Uhr Prototyp wurde gefiltert

Das Team hat seine Arbeit aufgeteilt. Team 1 konzentrierte sich darauf, die besonders schützenswerten Personen innerhalb der Polygone zu filtern und anzuzeigen. Team 2 widmete sich der Berechnung der Wetterbedingungen für ein bestimmtes Szenario. Dies wurde in einem agilen Arbeitsprozess parallel durchgeführt. Das Hauptziel bestand darin, den Bewegungspfad der Schadstoffwolke zu verfolgen und festzustellen, welche schützenswerten Personen sich innerhalb der Evakuierungszone befinden.

Es wird der Ereignisort als erster Punkt auf der Karte markiert, gefolgt von der Richtung und Geschwindigkeit der Schadstoffwolke als zweitem Punkt.

Die Filterungsergebnisse sind in diesem Bild zu sehen.

Derzeit fügen wir unsere Fortschritte zusammen. Es ist auch von grosser Bedeutung, das gesamte Projekt benutzerfreundlicher zu gestalten, damit dem Endbenutzer sofort die Anzahl der Personen im Allgemeinen sowie weitere Details angezeigt werden. Dieser Schritt wird jedoch nach der Mittagspause umgesetzt.

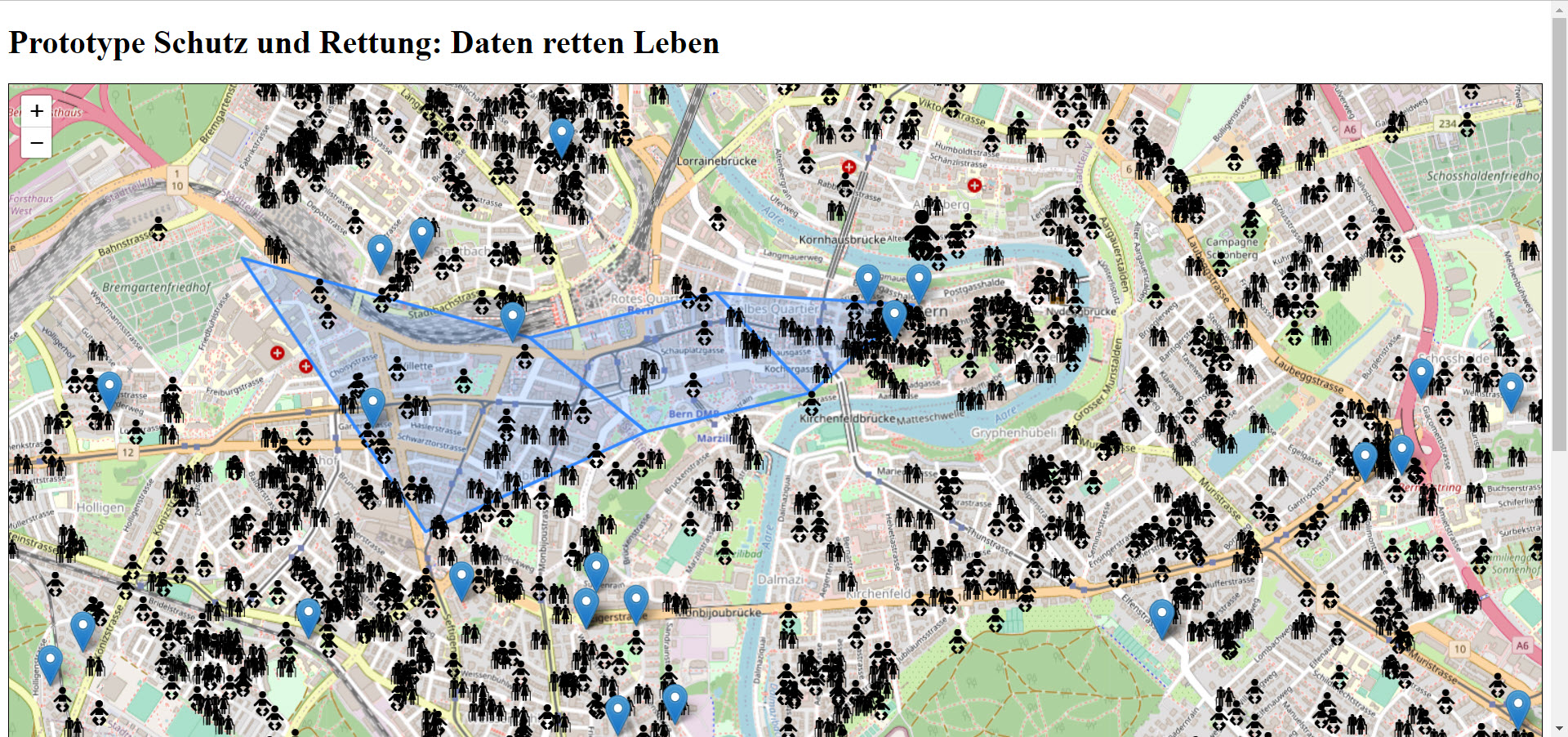

Uhr 20:00 Uhr Prototyp mit Test Daten ergänzt

Die Datenaufbereitung für die Karte erwies sich als herausfordernd. Wir führten intensive Meetings durch, um zu bestimmen, wie wir die Daten sammeln und publizieren können, um Bereiche zu analysieren, in denen besonders schutzbedürftige Kinder (unter 10 Jahren) und ältere Menschen (über 70 Jahren) leben. Um den Fokus auf die Benutzerfreundlichkeit zu legen, musste auf den ersten Blick erkennbar sein, wo sich diese besonders schutzbedürftigen Personen befinden. Wir haben spezielle Icons für diese Personengruppen ausgewählt. Zusätzlich mussten wir die Berechnung der Polygone durchführen und den Datenschutz sicherstellen. Um dies zu gewährleisten nutzten wir hier Test Daten.

Unser kleines Team hat sich jedoch als äusserst leistungsstark erwiesen, und wir sind schon nach wenigen Stunden zu einer familiären Gemeinschaft zusammengewachsen. Die Umsetzung gestaltete sich schwierig, da uns bestimmte Hardware-Elemente wie Monitore und Tastaturen fehlten. Dennoch haben wir alles auf Laptops programmiert und debugged. Unsere Motivation, Leben zu retten, ist weiterhin ungebrochen, und wir sind bereit, uns jedem noch so kleinen Fehler und jede fehlende Hardware Eskapade anzunehmen, um den Grundstein dafür zu legen.

Uhr 15:00 Uhr Erster Prototyp digitalisiert

Unser Motto lautet: "Keep it simple!" Dieser Leitsatz begleitet uns bei unseren ersten Versuchen. Wir haben bereits eine Webseite erstellt, jedoch ohne Daten. Der Challenge Owner zeigt sich begeistert von unseren ersten Schritten. Nun stehen wir jedoch vor der Herausforderung, die Daten bereitzustellen, um unser Vorhaben zu konkretisieren.

Uhr 12:10 Bedürfnisse wurden abgeklärt

Gemeinsam mit dem Challenger Owner haben wir seine genauen Anforderungen ermittelt. Wir haben ein Flipchart erstellt und unsere Visionen visualisiert. Tatkräftig sind wir aktuell an der Umsetzung des Prototyps und an der Entwicklung einer Software Lösung. Dabei wurden uns neue Möglichkeiten aufgezeigt, die unser Team hoch motiviert haben. Mit Blaulicht schreiten wird in diesem Projekt an.

DigiCheck

DigiCheck – Digitalkompetenz - wie gut bist du?

- Kompetenzmodell Kanton Bern

- Die Daten für die Challenge sind im Slack Channel (stehen ganz oben bei "gepinnt").

Repository mit allen Unterlagen:

Digiz – Plattform für Mitarbeitende Kompetenzen erlangen (lernen)

Inhalte entdecken

Austausch mit Anderen

Data Hackdays BE 2023

DigiCheck – Wie steht es um deine digitalen Kompetenzen? Selbstevaluation zu digitalen Kompetenzen 37 Fragen Kompetenzmodell

Data Hackdays BE 2023

DigiCheck – Ziel Zu viele Optionen überwältigen – personalisierte Empfehlungen helfen! User Profil

Data Hackdays BE 2023

Warum? Digitale Fähigkeiten sind heute in vielen Jobs unverzichtbar, wie E-Mail- und Office-Kenntnisse. Online-Kommunikation und Zusammenarbeit sind ebenfalls wichtig, um erfolgreich zu sein. Sie verbessern die Zusammenarbeit. In der digitalisierten Welt sind digitale Fähigkeiten entscheidend für individuelle und unternehmerische Zukunftsfähigkeit. Gute digitale Fähigkeiten erhöhen die Chancen auf Erfolg.

Data Hackdays BE 2023

Ressourcen und Hilfsmittel DigiCheck: Fragen sowie Hinweise zur Selbsteinschätzung Digitale Kompetenzen (Ergänzung zum Kompetenzmodell BE) Kompetenzmodell | Kompetenzen (be.ch) Linkliste zu öffentlich zugänglichen Inhalten zur Erweiterung der digitalen Kompetenzen Linkliste Mikrolerneinheiten digitale Kompetenzen Metadatenkonzept zur Beschreibung der Inhalte auf Digiz Ressourcenbeschreibungen Metadaten

Data Hackdays BE 2023

Erwartungen und Ausblick Die Entwicklung von Digiz startet ab Q3/2023.

Im besten Fall kann das Ergebnis der Hackdays vom Softwareentwickler weiterverwendet werden. Data Hackdays BE 2023

Challenge Owner Diana Nyffenegger Amt für Informatik und Organisation (KAIO) Abteilungsleiterin Ressourcen + Beschaffung Wildhainweg 9 3012 Bern

Individuelle Berner-Stadtspaziergänge

(04) Klicke dir deinen Spaziergang zusammen!

Challenge

Was?

- User*in wählt ein oder mehrere Stationen aus verschiedenen POI-Kategorien aus.

- User*in wählt Mobiltitätsform(en), die für sie/ihn in Frage kommen (zu Fuss, Fahrrad, ÖV, Kombination).

- Die Anwendung schlägt ihr/ihm die geeignetste Route und Verkehrsmittel vor.

- Die Route wird auf einer Karte dargestellt.

Darfs noch ein bisschen herausfordernder sein?

- Route in einem Navigationsmodus darstellen ("nach 40 m rechts abbiegen, dann..." + user-zentrierte Kartenansicht)

- Mobilitätsform Fahrrad resp. Kombination berücksichtigt Veloverleihsystem (PubliBike)

Warum?

Gängige Navigationsapps erfordern eine aufwändige Eingabe von Start, Ziel, gewünschten Zwischenstationen und Mobilitätsformen. Faktisch bestimmt oft der/die User*in die Route durch die Reihenfolge der Stationen. Die gesuchte Anwendung nimmt dem/der User*in diese Schritte ab und schlägt die optimale Route und Verkehrsmittel direkt vor.

Wer hat etwas davon?

Sämtliche Besucher*innen der Stadt, die ein oder mehrere Stationen in der Stadt besuchen möchten, den optimalen Weg/Verkehrsmittel jedoch nicht kennen.

Erwartung?

Funktionierender Prototyp einer entsprechenden Web-Anwendung, der Eingabe der gewünschten Stationen und Verkehrsmittel zulässt und anschliessend einen Routenvorschlag vornimmt und ggf. einen Navigationsmodus beinhaltet.

und/oder:

Generierung entsprechender Files (.gpx, .geojson, ...) zur Integration in weitere Applikationen.

Wie könnte es nach den Hackdays weitergehen?

- Gemeinsame Weiterentwicklung / Ausbau (Details tbd)

- Integration in Internet-Stadtplan der Stadt Bern (www.bern.ch/stadtplan)

- Integration in Bern Welcome App (https://www.bern.com/de/bw-app)

Daten und Tools

- POI (Points of Interest) Bern Welcome und Stadt Bern: https://map.bern.ch/download/Hackdays_SampleData.zip (.csv, .fgdb, .gpkg)

- Routing Service: bspw. Open Source Routing Machine (OSRM): http://project-osrm.org/

- Haltestellen ÖV (https://opentransportdata.swiss/de/

- PubliBike Standorte (https://opendata.swiss/de/dataset/standorte-und-verfugbarkeit-von-shared-mobility-angeboten)

- Mapservices Hintergrundkarten: bspw. https://opendata.swiss/de/organization/geoinformation-der-stadt-bern/?keywords_de=stadtplan (WMS / WMTS)

- Neue POI: 📎 POI_StadtBern_BernWelcome_Sample_EPSG4326.csv

indiv-berner-rundgaenge

To install all the dependencies, run the script:

./setup.sh

Architecture

Frontend

The frontend is an angular single page application.

It needs a build step for two reasons:

- To turn the angular code into a bundle that can be served by a web server

- To turn typescript code into pure javascript code that runs in the browser

To start it, do the following:

cd frontend

npm run start

Backend

The backend is a nest node application.

It needs a build step to transpile typescript into javascript.

To start it, do the following:

cd backend

npm run start:dev # will also start a mongo database in a docker container

Database

The database is a mongo database accessed by the backend.

Distribution

The provided dockerfile builds the frontend and backend and generates one image which will run both.

The following environment variables can be provided at runtime:

PRODUCTION: Can betrueorfalse. Sets some prod specific things and makes seeding impossible.SEED_MONGO: Can betrueorfalse. Whether to seed the mongo database.MONGO_URL: A string, should be a mongodb connection uri.MONGO_DB: A string, should be the name of the database to use.PORT: A number, the port to use instead of the default 3000.API_PREFIX: An optional prefix for the backend api. Defaults to/api.

Deployment

The provided docker compose file is an example for how to deploy the application.

Lageplattform Laienhelfer Kanton Bern

Visualisierung der Verfügbarkeit von freiwilligen (Miliz-) Einsatzkräften

Challenge

Stand heute

Szenario Notfall: Kreislaufproblem - Mensch bricht zusammen - 144. In der Einsatzleitzentrale (ELZ) erscheint der Anruf. Aufgrund des Standortes der Person bzw. des Gerätes, von dem der Notruf ausgeht, kann der Notfall genau lokalisiert werden. Daten, die das Telefon mitliefert oder öffentlich verfügbar sind, werden direkt der Einsatzleitung angezeigt. Die Position wird zuerst in einem grossen Radius dargestellt. Da alle 10s die Position abgefragt wird, wird der Radius aufgrund von sinkender Ungenauigkeit kleiner.

Die Mitarbeitenden der ELZ kümmern sich dann um die Alarmierung der Rettungskräfte. Dazu gehören neben professionellen Einsatzkräften auch First Responder. First Responder sind immer Unterstützung eines professionellen Rettungsdienstes und basieren auf Freiwilligenarbeit. Die Alarmierung geschieht in zwei Schritten: Zuerst werden die professionellen Kräfte aufgeboten. In einem zweiten Schritt geht ein Alarm an alle First Responder in der Nähe heraus, welche via Momentum Survive App aufgeboten werden. Helfende hinterlegen in der App ihre Verfügbarkeiten in Zonen (PLZ, Bezirke). Eine pro-aktive Standortübermittlung gibt es aktuell nicht. First Responder können ein Aufgebot an- oder ablehnen. Bei Annahme wird die Position des First Responders übermittelt und vom System überprüft, ob die Ambulanz schneller vor Ort ist. Falls nicht, erhält der First Responder den genauen Notfallstandort und wird für den Einsatz definitiv aufgeboten.

Pain Points

- Gibt es einen Notfall, können Laienhelfer einen wesentlichen Beitrag leisten. Zum Zeitpunkt einer Alarmierung weiss die ELZ aber nicht, wo wie First Responder sind. Alarmiert werden diejenigen First Responder, die sich für die entsprechende Gegend (PLZ) zur Verfügung gestellt haben. First Responder, die diese Gegend nicht angegeben haben, sich aber zum Zeitpunkt der Alarmierung darin befinden, können aktuell leider nicht alarmiert werden. Somit erfolgt die Alarmierung nicht genügend zielgerichtet.

- Die ELZ kennt die Standorte der First Responder nicht, bzw. erst wenn ein First Responder einen Einsatz annimmt. Eine genaue, pro-aktive Positionsermittlung ist für die strategische Planung relevant: Da in gewissen Gebieten zu bestimmten Zeiten mehr Notfälle auftreten, könnten Ressourcen besser disponiert werden (z.B. geografische Umverteilung der professionellen Rettungskräfte anhand von Ballungszentren der First Responder).

unsere Challenge / unser Lösungsansatz

Eine aktive Standortübermittlung der verfügbaren First Responder ist sinnvoll und notwendig. Dies müsste in einem Tool visualisiert werden. Was sind die Minimalanforderungen an ein solches Tool, die zwingend vorhanden sein müssen und was muss visualisiert werden?

Case 1: Notfall

Alle User:innen hinterlegen in der Momentum App ihre Zeiten, zu denen sie nicht verfügbar sind (z.B. Ferien). Ansonsten wird alle 500m oder alle 5min der Standort übermittelt. Im Falle eines Notfalls muss ein Einsatzteam innerhalb von 15min (bzw. 30min auf dem Land) vor Ort sein. Um den Notfallstandort erscheint ein 15min-Radius. Die ELZ wählt via Filteroptionen First Responder nach Kriterien wie Qualifikationen aus. So werden die gewünschten und verfügbaren First Responder mit genauem Standort in der Nähe des Einsatzes angezeigt. Die Einsatzleitung kann so schneller und einfacher alle gewünschten First Responder aufbieten. Durch die Genauigkeit der Standorte der First Responder, erhöht sich die Quote einer erfolgreichen Aufbietung der First Responder.

Case 2: kein Notfall

Liegt kein Ereignis vor, kann die ELZ die Zeit nutzen um verfügbare Ressourcen sinnvoll zu disponieren. So ist zum Beispiel bekannt, dass mehr Einsatzkräfte am Freitagabend in der Berner Innenstadt benötigt werden. Hierfür muss jedoch die Position der First Responder in der Zukunft bekannt sein. Dazu zieht das Tool zwei Daten heran: die im Tool hinterlegten Verfügbarkeiten sowie die anonymisierte History der Standortdaten. Damit wird eine Heatmap mit Zeitachse der First Responder generiert. Die visuelle Darstellung hilft der ELZ Engpässe im Voraus zu erkennen und entsprechende Massnahmen zu treffen (Verschiebung der professionellen Einsatzkräfte).

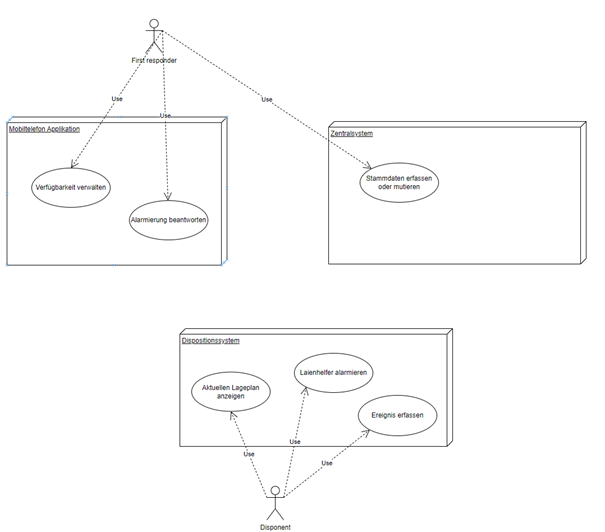

Konzeption & Datenstruktur

Neue Use Cases

- Anzeigen, wo ausreichend Laienhelfer verfügbar sind. Ausreichend ist in Bezug auf einen Soll-Deckungsgrad zu verstehen.

- Alarmierung: Genau jene Laienhelfer benachrichtigen (genauer gesagt: anfragen), die näher am Ereignisstandort sind als professionelle Einsatzmittel, zudem verfügbar sind und die benötigten Qualifikationen haben.

- Professionelle Einsatzmittel anhand des aktuellen Lagebildes steuern a. derzeitige Disposition der professionellen Einsatzkräfte darstellen b. Standorte / Heat Map der Laienhelfer darstellen c. dies für verschiedene Qualifikationen

- Langfristige Massnahmen um Soll-Deckungsgrad zu erreichen

Anforderungen

Systemanforderungen: Mobiltelefon-App

- Das System muss alle 15 Minuten den Standort eines zu diesem Zeitpunkt verfügbaren Laienhelfers erfassen und an das Zentralsystem übertragen. Der Standort muss mit einer Lage-Genauigkeit von 1000 Metern und einer zeitlichen Genauigkeit von einer Minute übertragen werden

- Das System muss im Alarmierungsfall ein push-Nachricht auslösen

- Das System muss im Akzeptanzfall dem Laienhelfer die Position und Beschreibung des Ereignisses anzeigen

- Das System muss die Verwaltung der eigenen Verfügbarkeit erlauben

Systemanforderungen: Zentralsystem

- Das System muss die Qualifikationen eine Laienhelfers verwalten (inkl. Verifizierung durch Dritte)

- Das System muss demographische Daten des Laienhelfers verwalten, die zu seiner Identifizierung dienen

- Das System muss die Mobiltelefonnummer des Laienhelfers verwalten

- Das System muss eruieren, welche Laienhelfer (die verfügbar sind und die richtigen Qualifikationen haben), vor dem professionellen Einsatzmittel am Standort sein können

- Das System muss eine push-Nachricht auf Mobiltelefonen auslösen und die Antwort registrieren können

Systemanforderungen: Data Mart

- Das System muss die Standorte historisieren

- Das System muss die gültigen Qualifikationen (d.h. verifiziert und nicht abgelaufen) historisieren

Systemanforderungen: Dispositionssystem (ELZ)

- Das System muss die Verfügbarkeit der verschiedenen Qualifikationen anhand der tatsächlichen Standorte auf einer Karte darstellen. Dabei ist eine Farbskala zu verwenden, die das Erreichen oder Unterschreiten eines pro Standort und Zeitpunkt definierten Soll-Wertes codiert.

- Das System muss die professionellen Einsatzkräfte auf derselben Karte darstellen. Dabei ist ihr Einsatzradius farblich zu codieren.

- Das System muss berechnen, wann das erste professionelle Einsatzmittel am Ereignisstandort eintrifft

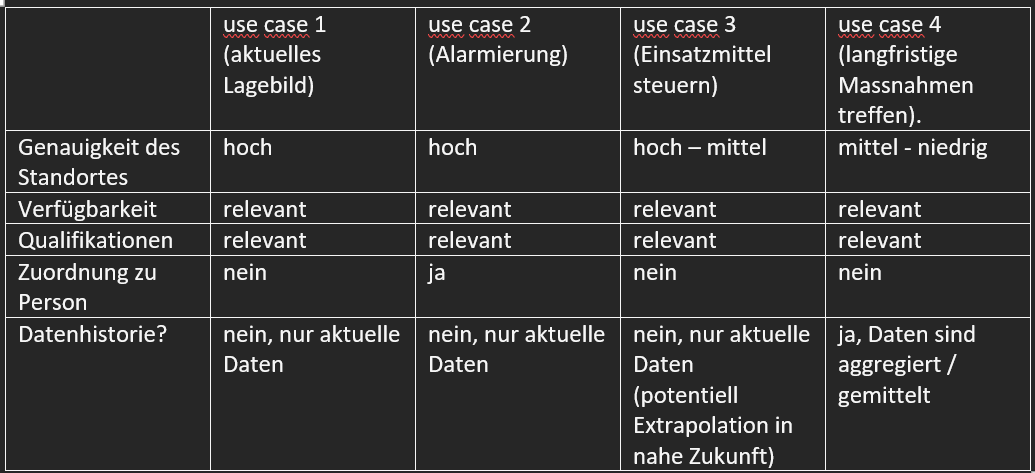

Datenanforderungen für die verschiedenen Use Cases

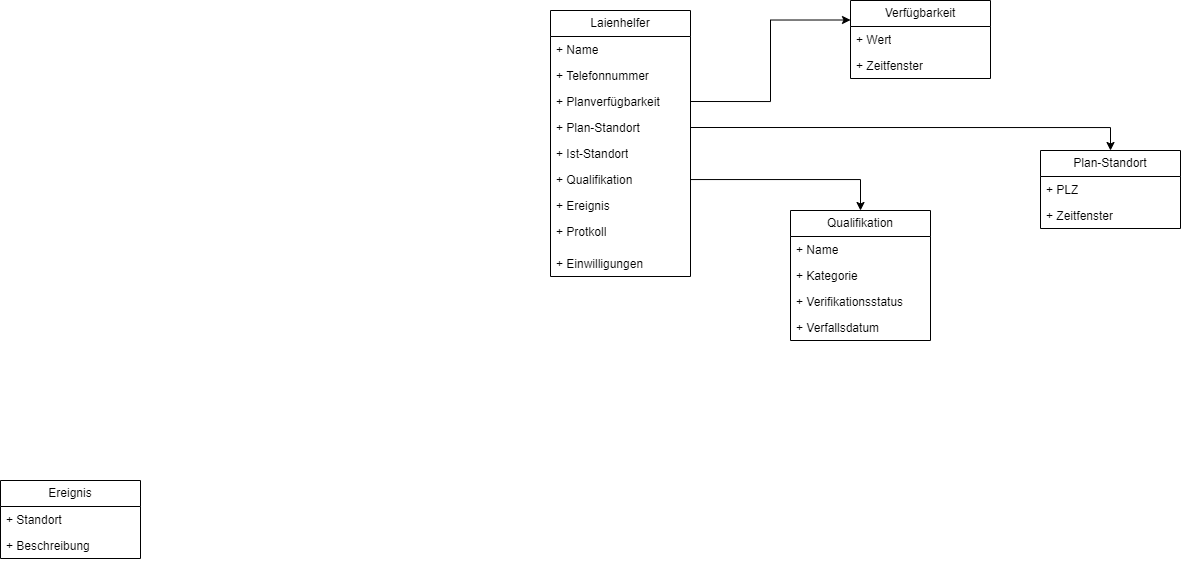

Datenmodell

Architekturen

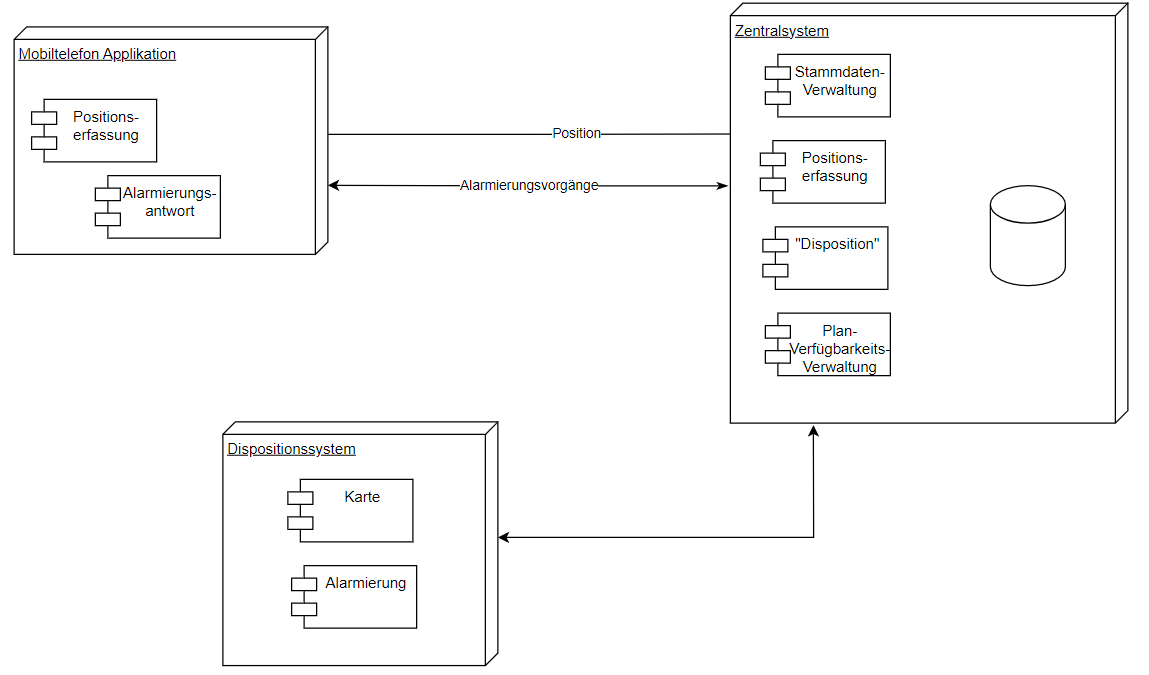

Ist-Systemarchitektur

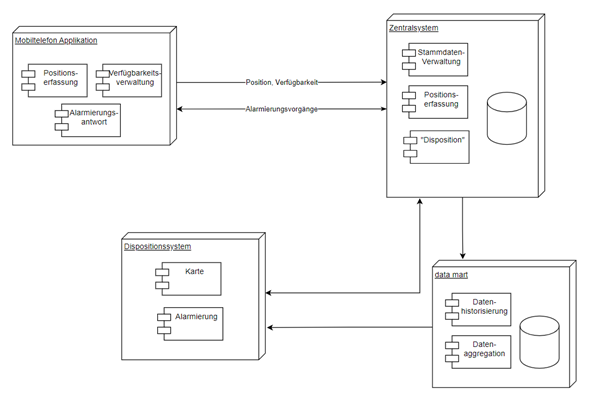

Soll-Systemarchitektur

Business Case

- Wie viele Laienhelfer werden heutzutage angefragt, erklären sich bereit und werden dann abgelehnt (weil nicht nahe genug)?

- Wie viele sind nicht an dem Ort, wo sie «sein sollten»?

- Wie viel wären vor Ort, werden aber nicht benachrichtigt?

Kommentare zu Annahmen, die getroffen worden sind

- Die exakte Unschärfe der Position und Zeit müssen definiert werden

- Wo die Unschärfe hineinkommt (in der App oder im Zentralsystem), ist zu bestimmen

- Datenschutz wird eingehalten

Visualisierung Mockup

Verwendete Programme: Adobe: XD, Illustrator, Photoshop

Anhand unseres Screen Designs des Tools soll veranschaulicht werden, wie die Prozesse ablaufen. Hierfür erstellten wir zuerst Wireframes in Adobe XD. Eine grosse Herausforderung war allerdings, die vielen und sehr unterschiedlichen Faktoren zu berücksichtigen, diese herunterzubrechen und abzuschätzen, welche davon effektiv Relevanz haben. Aufgrund von Zeitmangel entschieden wir uns für eine UX-Gestaltung on the fly. Wir fokussierten uns auf die essentiellen, zu visualisierenden Daten und vereinfachten diese in einem UI.

https://www.youtube.com/watch?v=25s-0-knk54

https://xd.adobe.com/view/0d265456-2575-403d-8034-1ba2bf2192f2-5875/?fullscreen

Lageplattform Laienhelfer Kanton Bern Visualisierung der Verfügbarkeit von freiwilligen (Miliz-) Einsatzkräften 12. und 13. Mai 2023 Data Hackdays BE 2023 1

Um was geht es? Die BORS (Behörden und Organisationen für Rettung und Sicherheit) im Kanton Bern werden durch Einsatzzentralen der Polizei, Sanität und Feuerwehr koordiniert, disponiert und alarmiert. Die Berufsformationen der Organisationen sind in den Einsatzleitsystemen hinterlegt. Es können sowohl die Standorte wie auch die personellen und materiellen Ressourcen sowie den Status der Einsatzmittel angezeigt werden. Im Bereich der freiwilligen Helfer fehlen diese Informationen weitgehend. Dies führt dazu, dass diese Formationen nicht disponiert sondern nur alarmiert werden können. 12. und 13. Mai 2023 Data Hackdays BE 2023 2

Warum? Die Alarmierung von freiwilligen Formationen sowie Laienhelfern erfolgt in der Regel aufgrund vordefinierter Gruppen, in der Hoffnung, zeit- und lagegerecht genügend Einsatzkräfte am Einsatzort zu haben. Aufgrund der fehlenden Informationen über die Verfügbarkeit sowie den Status dieser Einheiten können diese nicht oder nur beschränkt in strategische Überlegungen mit einbezogen werden.

Eine strukturierte Übersicht über die zur Verfügung stehenden Ressourcen dient der Einsatzzentrale und damit nicht zuletzt den hilfesuchenden Personen zeitgerecht die möglichst passende Hilfe zu erhalten.

- und 13. Mai 2023 Data Hackdays BE 2023 3

Ressourcen und Hilfsmittel Daten Momentum ARMC API Anbindung an Webapplikation von surevive.ch

Unterlagen Firstresponder.be Hier melden sich geeignete Personen auf einem System an. Im Ereignisfall werden diejenigen Personen alarmiert, welche sich für eine bestimmte Region eingetragen haben. Nach der Entgegennahme des Alarms wird der Standort des First Responders eruiert und mit anderen Rückmeldungen abgeglichen. Schlussendlich erhalten nur diejenigen Helfer den effektiven Alarm mit Adresse, welche vor den professionellen Diensten (Ambulanz) vor Ort sein können. 12. und 13. Mai 2023 Data Hackdays BE 2023 4

Erwartungen Am Ende der Hackdays sollte eine grobe Struktur eines möglichen Lagevisualisierungssystems vorliegen. Es soll definiert sein, welche Daten für eine solche Lageplattform nötig wären und wie sie dargestellt werden könnten (Listen, Karten, Diagramm, etc.)

Für die Lagedarstellung soll davon ausgegangen werden, dass es keine rechtlichen Hindernisse in Bezug auf Datenschutz, -speicherung und -zugang gibt. 12. und 13. Mai 2023 Data Hackdays BE 2023 5

Outlook Möglicherweise könnten Erkenntnisse in eine Machbarkeitsstudie für eine operativ nutzbare Lageplattform einfliessen.

In einem weiteren Schritt könnte die Alarmierung geeigneter Einsatzmittel aufgrund der zur Verfügung stehenden Daten betrachtet werden. 12. und 13. Mai 2023 Data Hackdays BE 2023 6

Callenge Owner Spühler Christian Kantonspolizei Bern, Planung und Einsatz

Mass der Identifizierbarkeit

Lassen scheinbar anonymisierte Daten wirklich keine Rückschlüsse auf Individuen zu? Wir wollen das messen.

Daten zu Individuen sollen weitergegeben werden können. Aufgrund dieser Daten sollen keine Rückschlüsse auf einzelne Individuen möglich sein. Hierzu werden die Daten vorgängig anonymisiert. Es gilt zu prüfen, ob diese Anonymisierung bei einem Datensatz ausreichend gelungen ist?

Es müssen Ansätze gefunden werden, wie sich sich die Anonymisierung messen lässt? Diese Ansätze sollen in ein Tool integriert werden.

Sammlung von Begriffen & Bemerkungen & Links

📎 Übersicht zur Anonymität (PDF)

Save the Data - .docx im Jahre 2133

Die Zukunft der Daten in der kantonalen Verwaltung des Kantons Bern

Viele der in der Kantonsverwaltung erzeugten Daten wurden im .docx-Format erstellt. .pdf ist der große Konkurrent, allerdings ist der Großteil der Datenproduktion in der Kantonsverwaltung im OOXML-Format (.docx).

Obwohl .docx das am häufigsten verwendete Format ist, wird für die Archivierung nicht als archivtaugliches Format zugelassen. Die verschiedenen Word-Versionen, die es gibt, und gewisse Funktionen (z. B. automatisch aktualisierte Felder) können zu veränderbarem Inhalt führen. Deswegen ist es empfohlen für die Archivierung jedes Word Dokument in pdf/A-2u zu konvertieren. Die Konvertierung führt aber zu Informationsverlust.

Gemäss Wikipedia ist Word "das mit Abstand meistverwendete Textverarbeitungsprogramm der Welt". Es ist auch ein Dateiformat das bereits 40 Jahren auf dem Markt ist. Wird Word weitere 40 Jahre existieren? Diese Möglichkeit besteht und deswegen fragen wir uns, ob es möglich wäre die Unterlagen auf .docx, das heisst im Originalformat, zu archivieren.

In dieser Challenge fördern wir, dass einer Software entwickeln wird, der eine Analyse von .docx Dokumenten macht und dass die kritischen Elemente im Bezug von Veränderbarkeit von .docx beschreibt. Zusätzlich möchten wir, dass ein neues archivtaugliches Word-Dokument erstellt wird.

Unterschiedliche Versionen von Microsoft Word OOXML:

https://github.com/digital-preservation/droid

Microsoft Word 1.0 - Internet Archive

Weitere Daten für die Challenge sind im Slack Channel verfügbar.

Docx Date Converter App

This simple Application allows users to select a Docx file to be analyzed. The analysis consists of checking if there are any variable fillable fields in the document, replacing them in the XML source code with a static value, and delivering a set of relevant metadata values for the analyzed document. For the first version, the solution will focus only on replacing variable date fields, which would otherwise be automatically filled by Microsoft Word after opening the document. Date values will be replaced by a static date at the time of analysis. This application converts .docx files that have a dynamic date field and saves them with a static date of the data when the .docx was created. It is a solution to the challenge of preserving the integrity of .docx files in archival systems.

The solution consists of three parts:

-

Front-End (React, Electron)

-

API (Python)

-

Back-End (Python)

The Challenge

A large portion of data produced within the Canton Administration is created in the .docx format. Despite .docx being the most frequently used format, it's not permitted for archival due to potential inconsistencies across different Word versions and functions (e.g., automatically updated fields) that can lead to mutable content. Therefore, it's recommended to convert every Word document to pdf/A-2u for archival purposes, but this conversion leads to information loss.

We ask the question: "Could we archive documents in .docx, i.e., in their original format, given that Word has been a prominent document format for 40 years and might continue to be for the next 40 years?"

This challenge aims to develop software that performs an analysis of .docx documents, identifies critical elements concerning the mutability of .docx, and creates a new archive-friendly Word document.

Running the Software

To run the software, you need to have both Python (for the Flask backend) and Node.js (for the React frontend) installed on your machine.

Setup

-

Clone this repository:

git clone git@github.com:LucaKern/Save-the-Data---.docx-im-Jahre-2133.git -

Navigate to the project directory:

cd Save-the-Data---.docx-im-Jahre-2133 -

Install the Node.js dependencies:

npm install -

Navigate to the backend directory:

cd ./backend -

Create a virtual environment:

python -m venv venv -

Activate the virtual environment:

-

On Windows:

venv\Scripts\activate -

On Unix or MacOS:

source venv/bin/activate

-

-

Install the Python dependencies:

pip install -r requirements.txt -

Navigate to the electron app:

cd ./frontend

Running the App

To start the application, run the following command:

npm start

Further Case Analysis

DOCX files, commonly used for document storage and sharing, may not be optimal for long-term archiving due to several factors:

-

Compatibility: DOCX is a file format associated with Microsoft Office applications. While it enjoys widespread support presently, there is no assurance of its future dominance. If you rely on specific software to access DOCX files, there is a risk of obsolescence or incompatibility with newer systems, hindering retrieval of archived documents.

-

Backward Compatibility: With each new release, Microsoft Office introduces changes to the DOCX format. Opening older DOCX files with newer Office versions can result in formatting errors, missing content, or altered document layout. Such issues pose challenges when accessing archived files after a significant duration.

-

Data Corruption: Over time, files may experience corruption or degradation due to hardware failures, software bugs, or storage media issues. Due to the dependencies and complexity of the DOCX format, it is relatively more susceptible to integrity problems. Repairing corrupted DOCX files can be challenging, potentially leading to data loss or incomplete retrieval of archived documents.

-

Long-Term Storage Standards: For long-term archiving, employing open, standardized file formats is recommended. Formats like PDF/A2-u, designed specifically for archiving, ensure document preservation and accessibility over extended periods. These formats are independent of specific software vendors, enhancing compatibility and longevity.

While converting important documents to standardized formats like PDF/A2-u is generally advised for long-term archiving, it is worth noting that the widespread use and potential future developments surrounding DOCX could contribute to its acceptance as an archival standard. Factors such as popularity, backward compatibility efforts, support from Microsoft, industry acceptance, and technological advancements might enhance the reliability of DOCX as an archiving format. However, until industry-wide acceptance and preservation efforts validate its suitability, adhering to current best practices by relying on standardized formats like PDF/A2-u for long-term archiving remains a prudent approach.

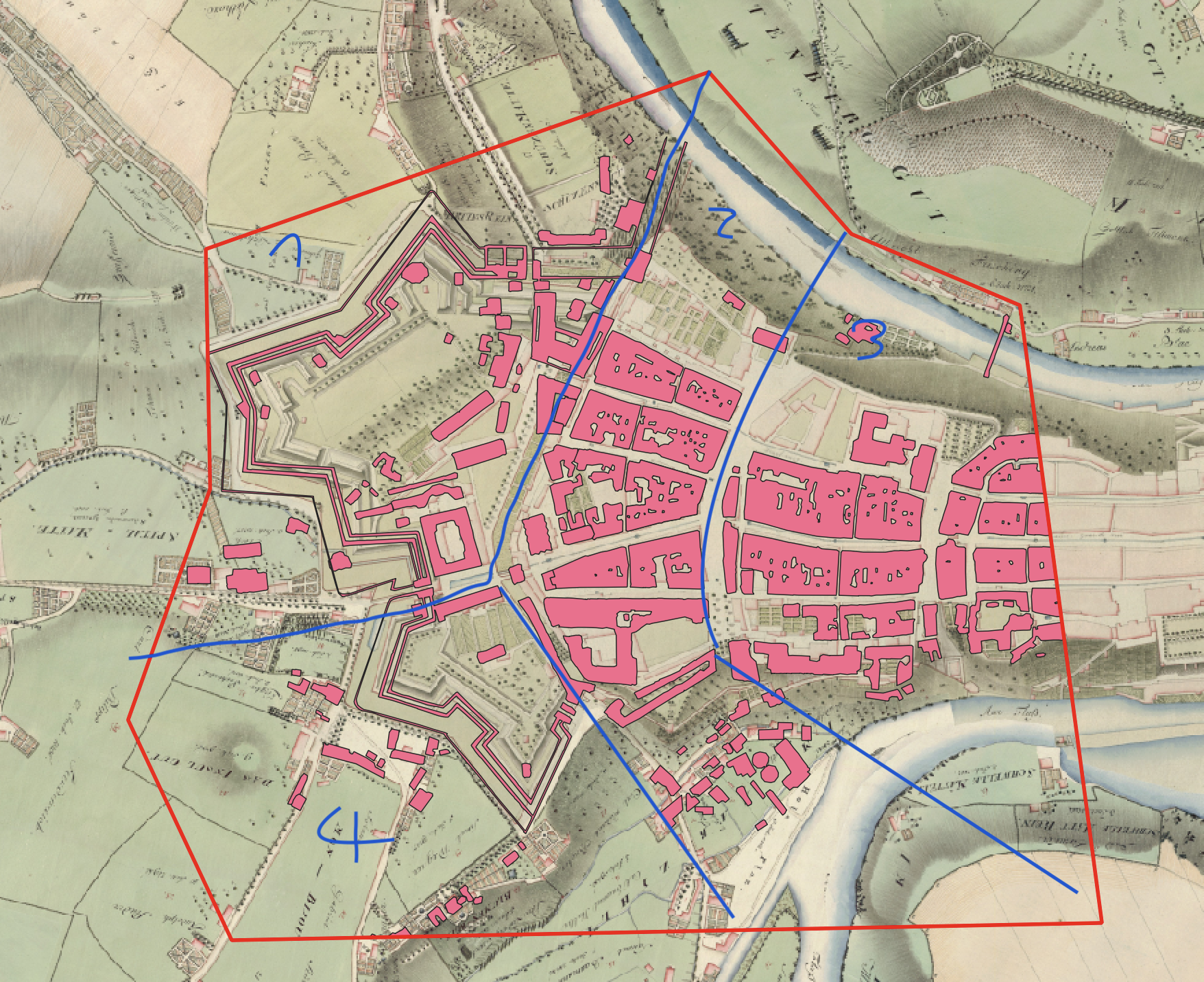

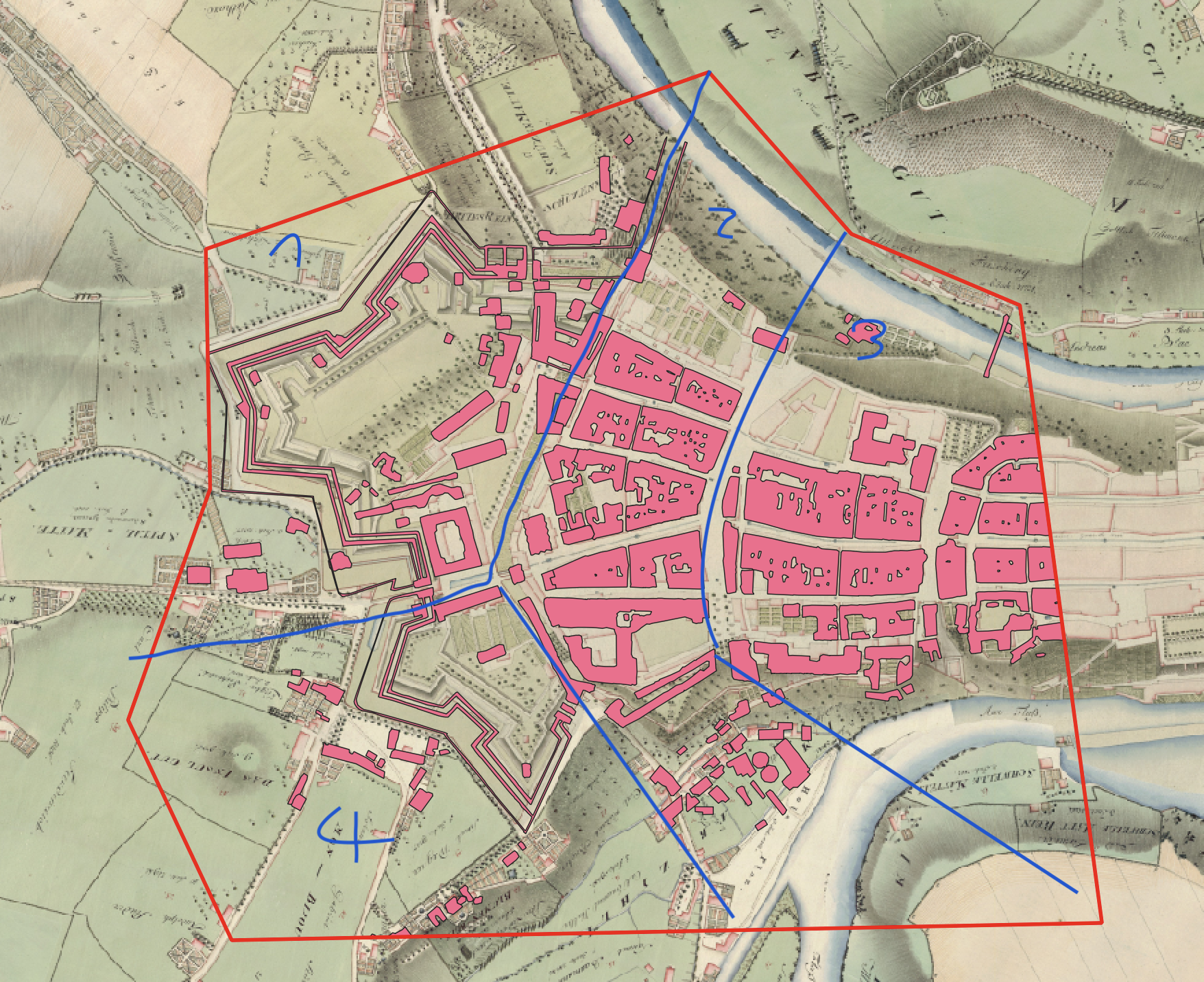

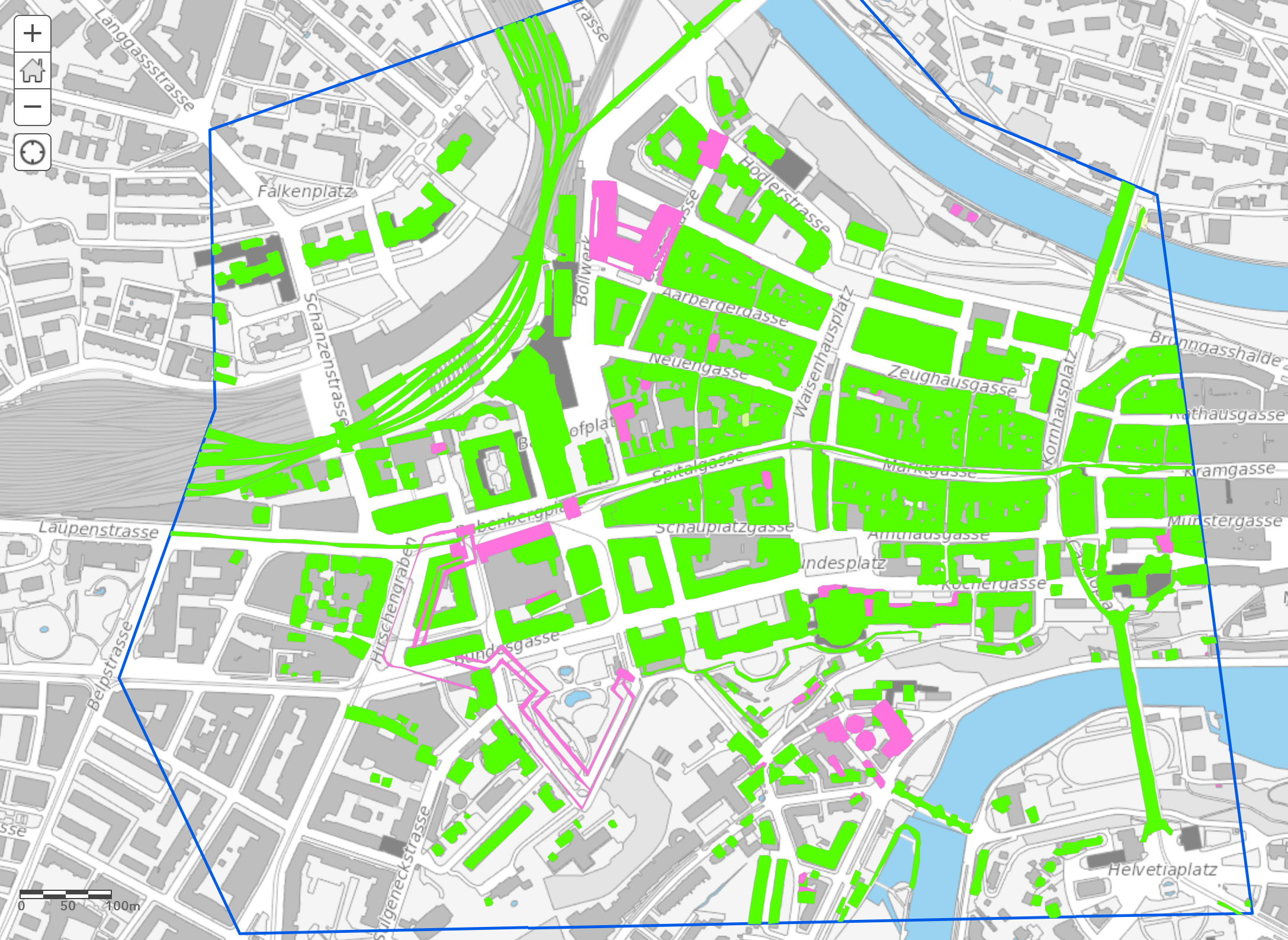

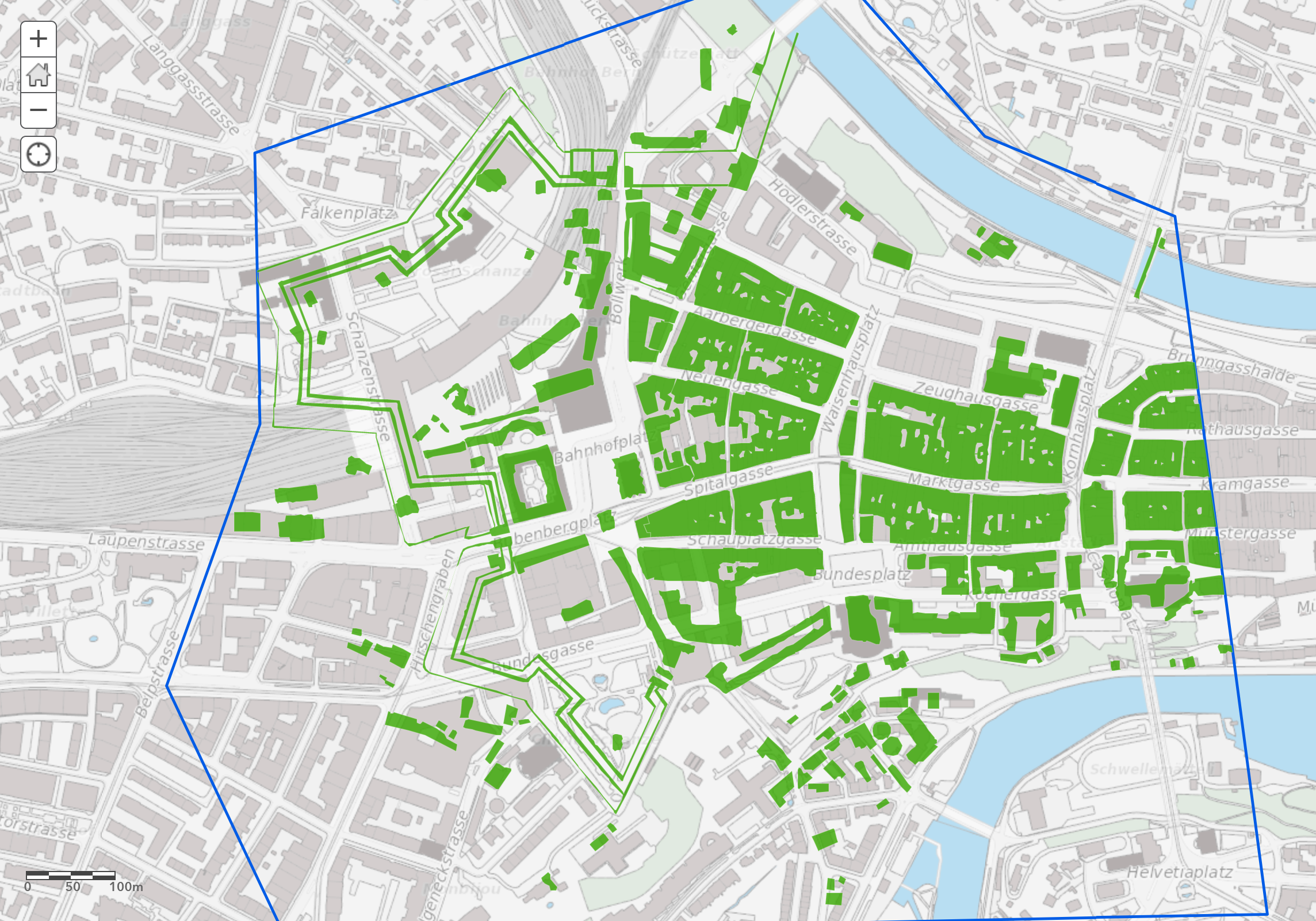

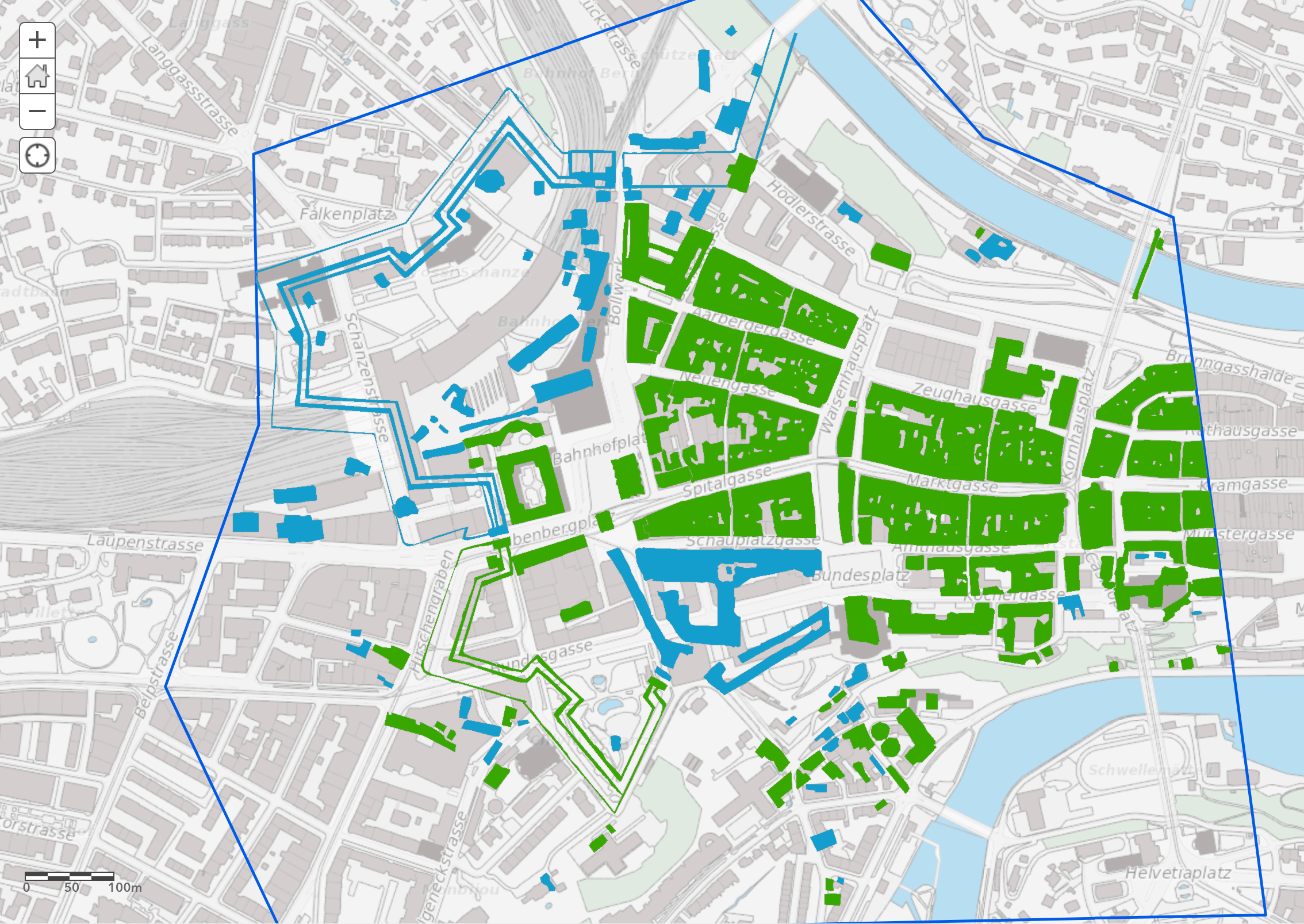

Stadtentwicklung in 3D

Visualisierung der baulichen Entwicklung als 3D-Modell – von 1800 bis heute

- ⏯️ Stadtentwicklung 3D Animation Final

- 📦 File: Pitch 3D Stadtentwicklung.pdf

- 📎 Challenge Slides (PDF)

- 📎 Liste Grundlagedaten Teilnehmer.pdf

- 📎 Links online Ressourcen.pdf

- 📦 File: Wichtigste Entwicklungen Altstadt.pdf

Präsentation

Stadtentwicklung in 3D

Visualisierung der baulichen Entwicklung als 3D-Modell – von 1850 bis heute

Wie packen wir das an?

- Recherche historischer Daten

- Technische Umsetzung...

- Erste Idee - Aufbereitung in QGIS, Zusammenführung in Blender, 3D Darstellung in Unity

- Revidierte Idee - Nutzung von Open Source > Bearbeitung in QGIS, Verzicht auf Blender und Unity, auch aus zeitlichen Gründen

Welche Daten verwenden wir?

- Sichtung - welche Daten haben wir überhaupt?

- Auswahl - Selektion des relevanten Gebiets

- Zeitliche Auswahl: Epochen 1850, 1900, 1925, heute

Wie sehen die Daten im Detail aus?

- Rasterdaten

- Historische Stadtpläne (georeferenziert)

- Luftbilder

- Vektordaten

- Bauentwicklung pro Zeitepoche (Polygone)

- Bauhistorie (Polygone mit Freitext-Attributen)

- Footprints des aktuellen 3D-Stadtmodells

- 3D-Vektordaten

- Aktuelles 3D-Stadtmodell

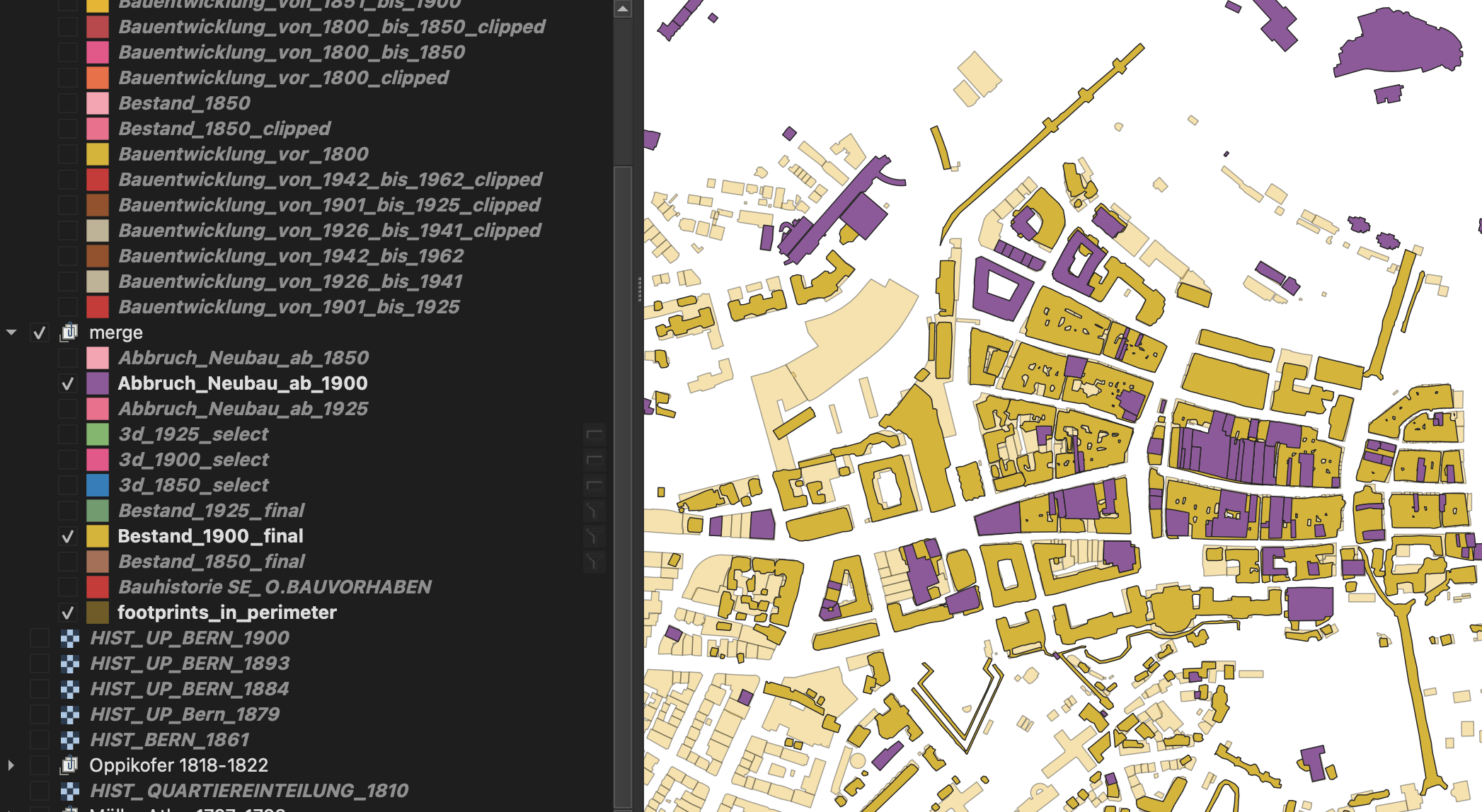

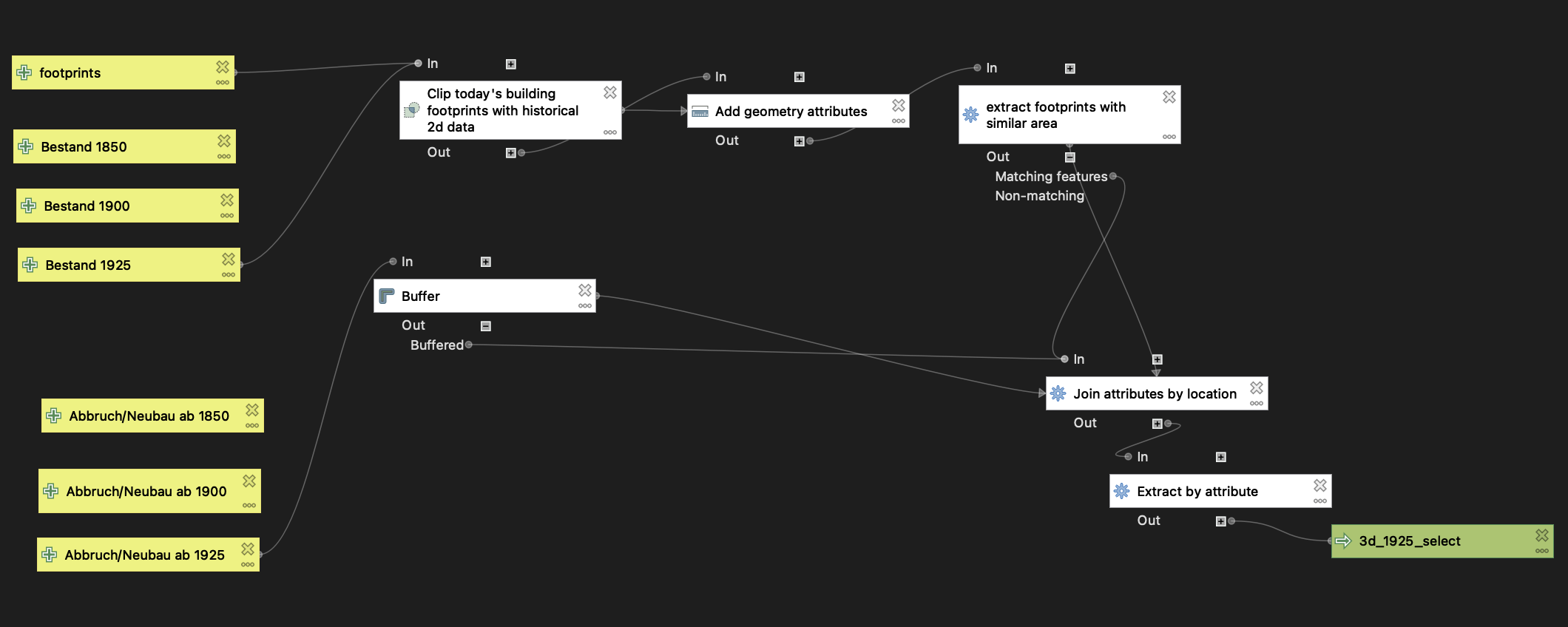

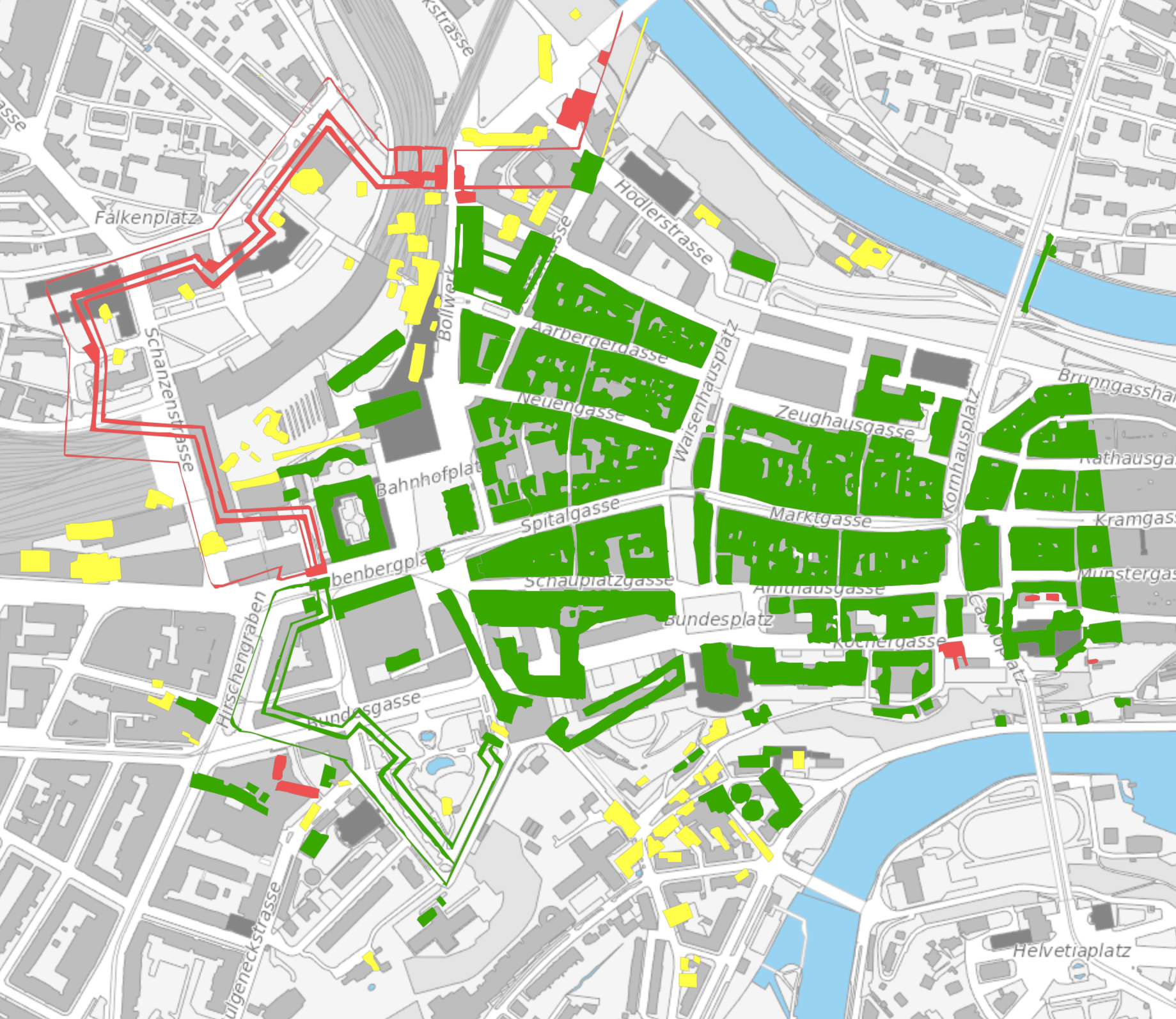

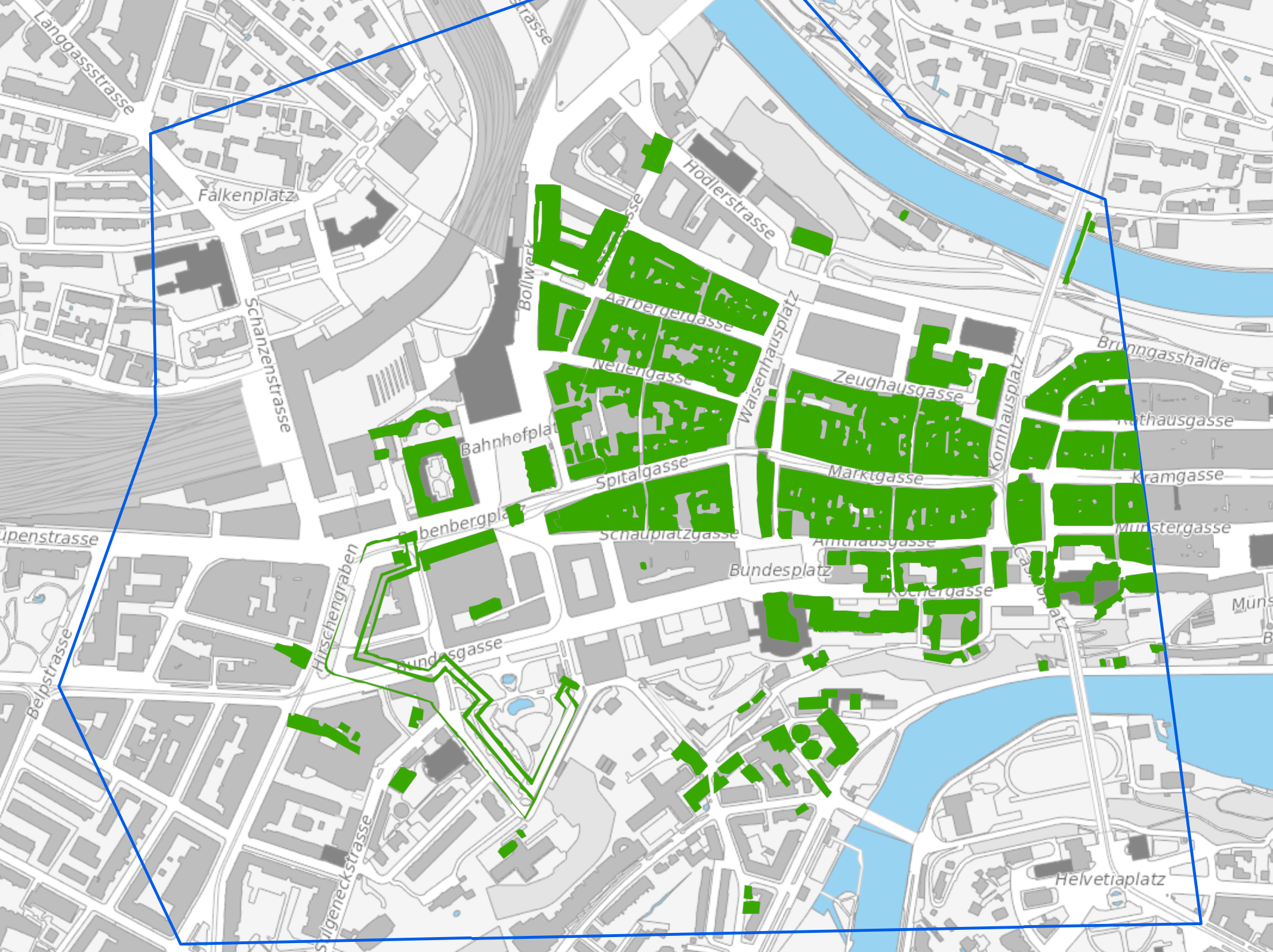

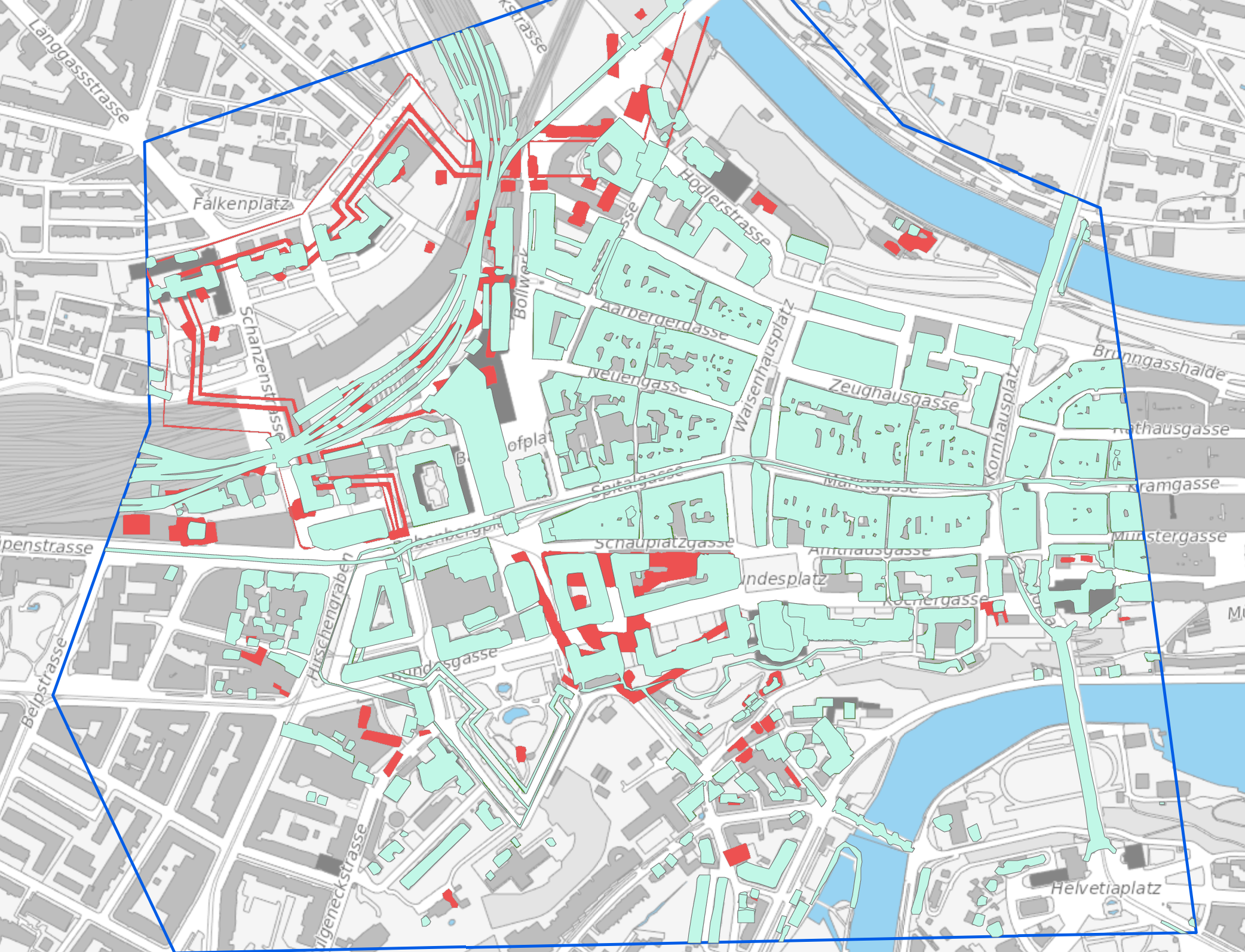

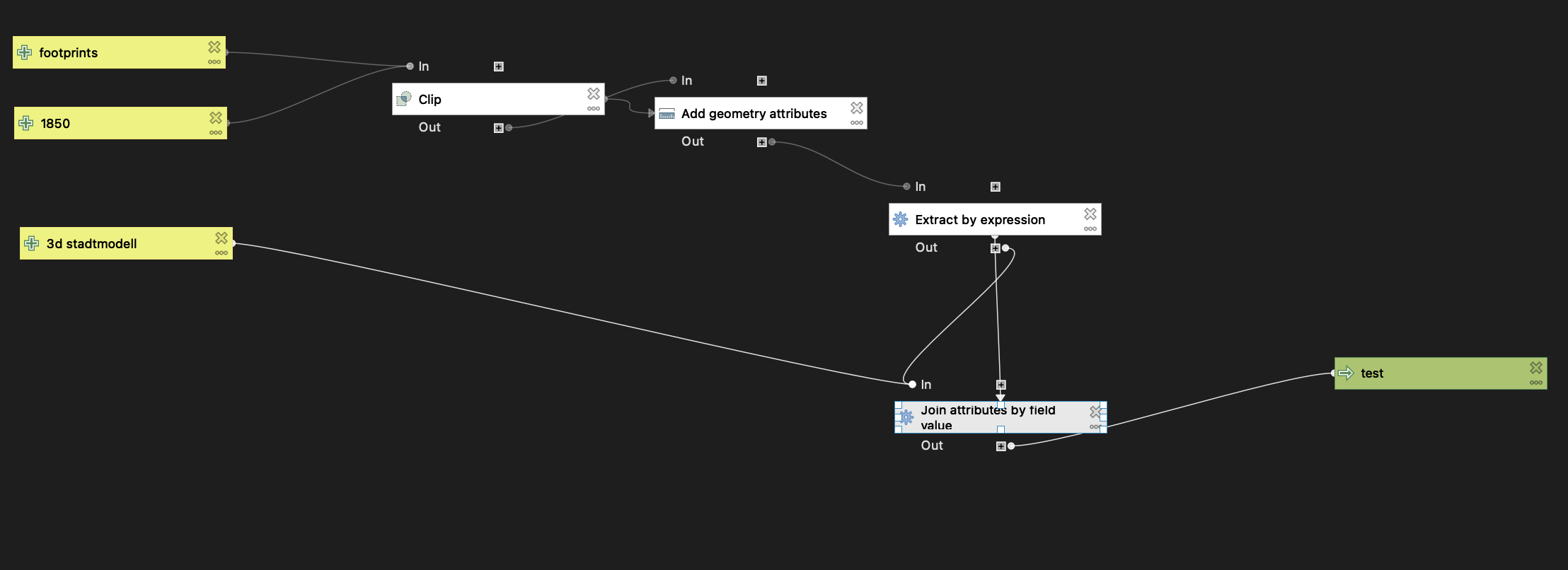

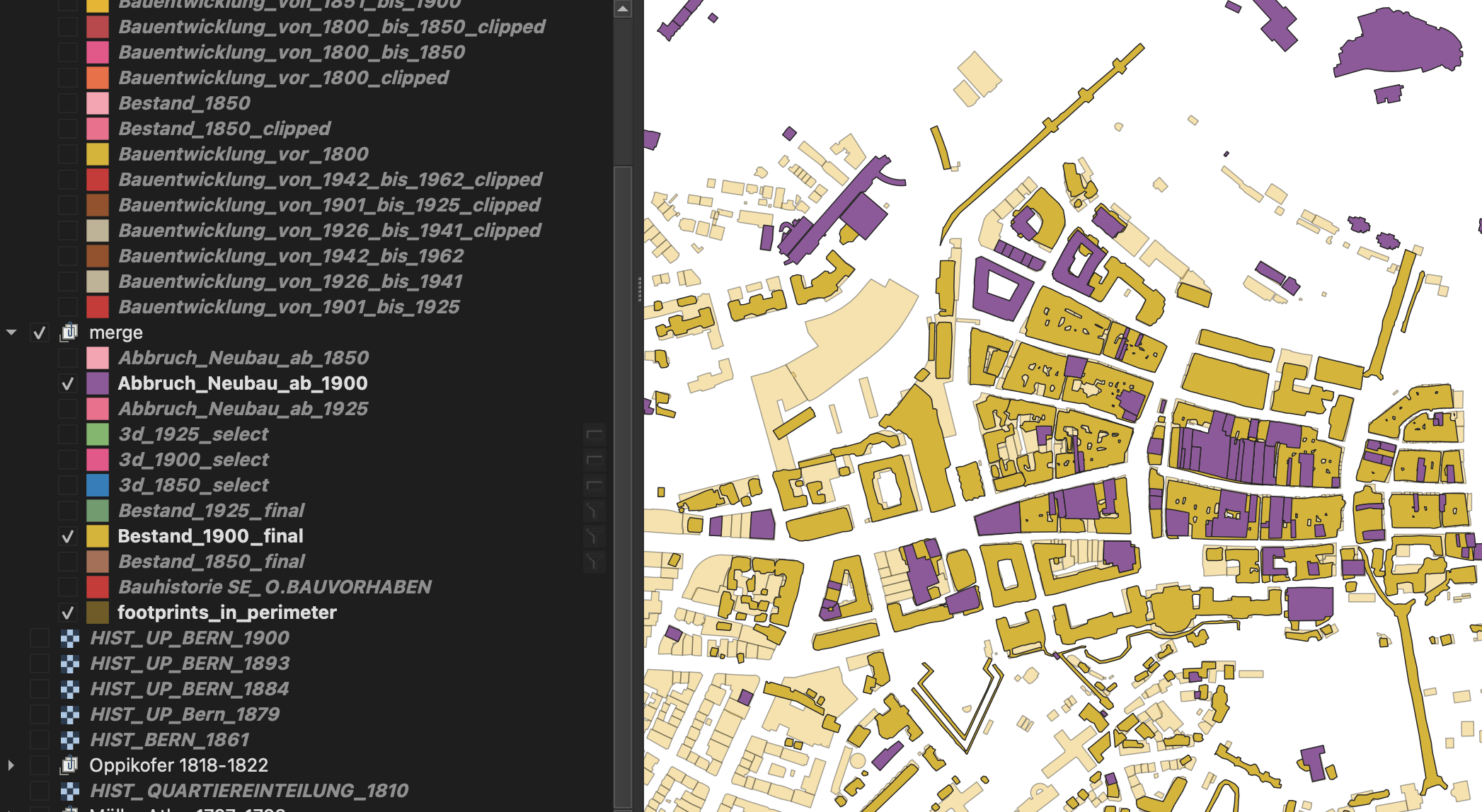

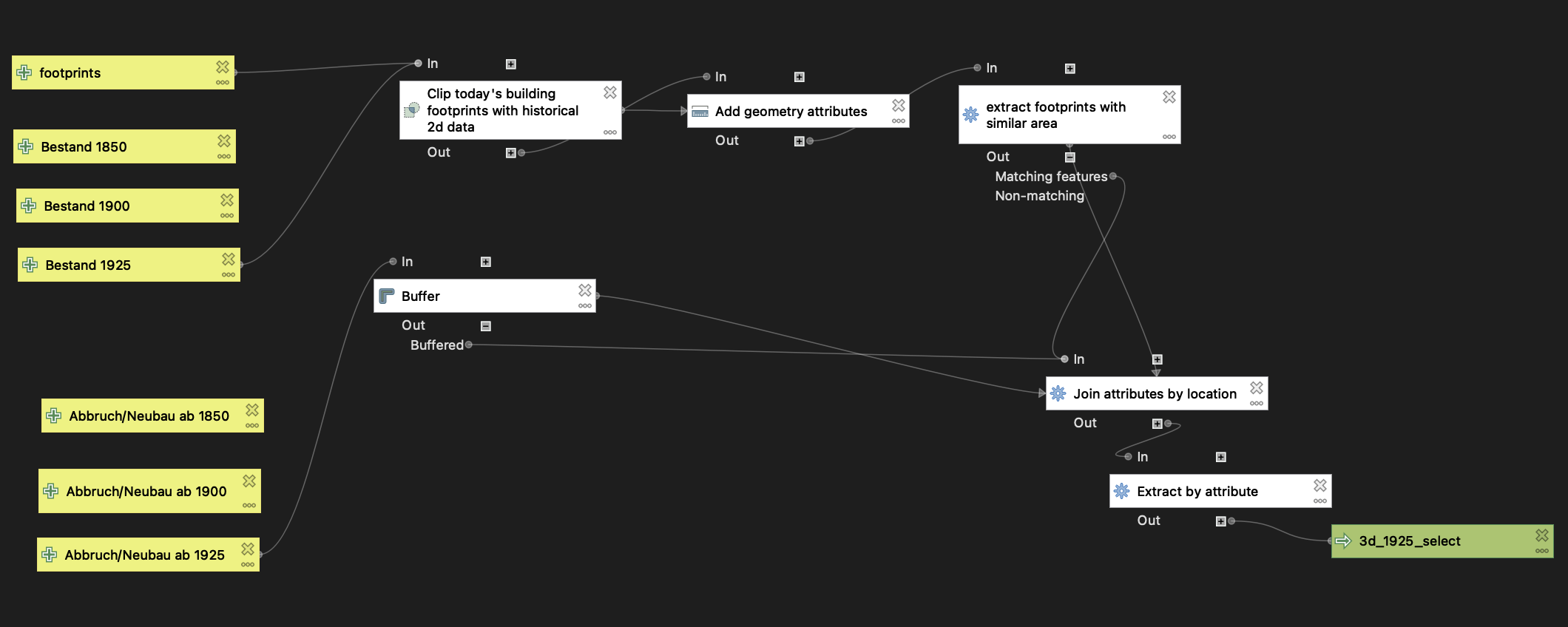

Wie kombinieren wir die Daten?

- Kumulation der neu erstellen Bauten über mehrere Epochen

- Manuelle Klassifizierung des Gebäudebestandes zu versch. Epochen

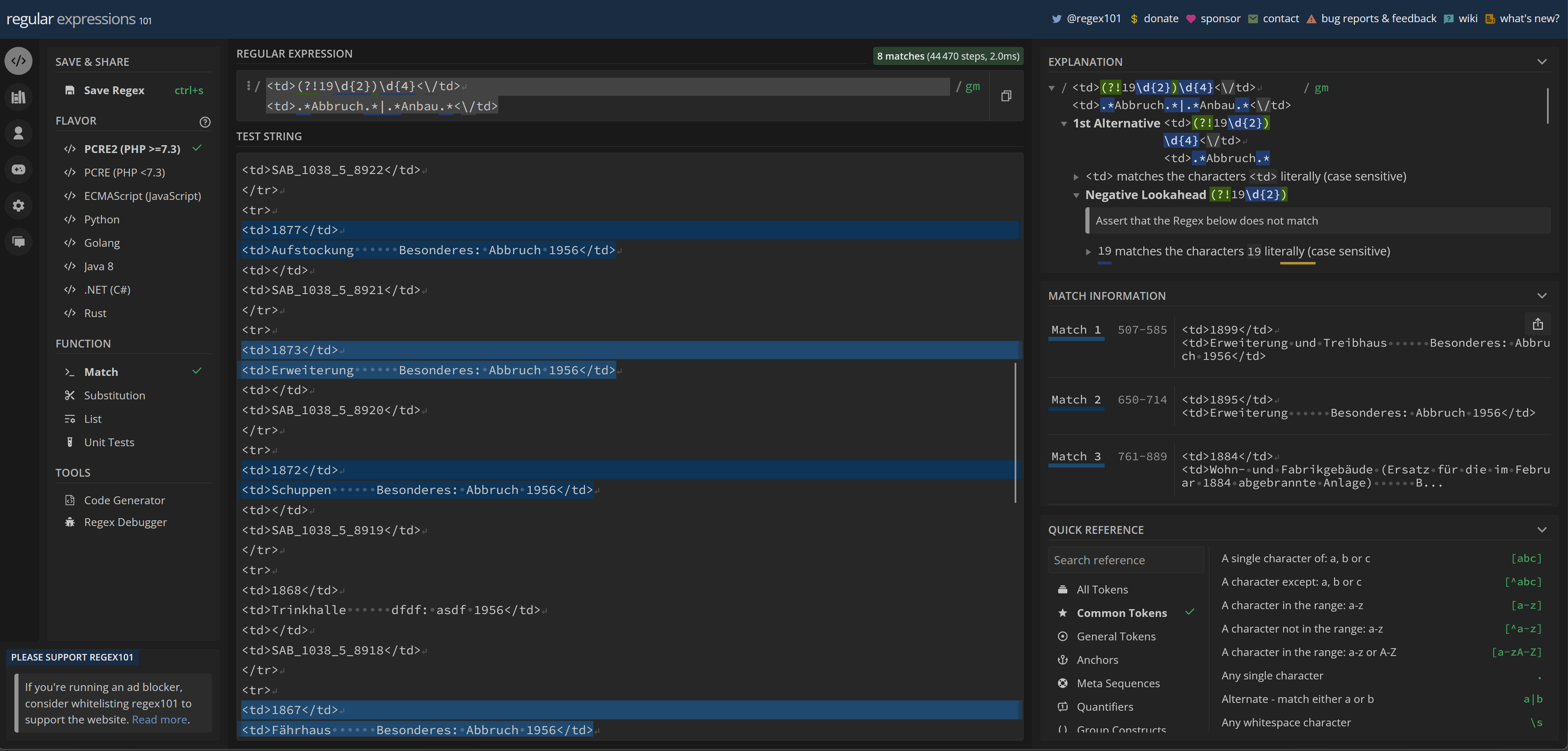

- Automatisierte Klassifizierung von Freitextattributen (RegEx-Abfrage in QGIS)

- Räumliche Verschnitte (QGIS Model Builder)

Was haben wir erreicht?

- Liste von Gebäuden des aktuellen 3D-Modells, die zu historischen Zeitpunkten bereits existiert haben

- Grundrisse von "allen" Gebäuden, die zu historischen Zeitpunkten bestanden haben -> können vertikal extrudiert werden (Höheninformation aktuell nur geschätzt)

- Workflow, um historische Daten verschiedenster Formate in dreidimensionale Information umzuwandeln

Finally - die Visualisierung

ArcGIS Enterprise 3D Scene

Unser cooles Projektteam

Danke für die tolle Zusammenarbeit!

Isabelle Bai, Peter Janes, Debora Leuenberger, Simon Hischier, Daniel Oetterli, Christian Peier, Felix Piringer, Bernhard Klöti, Patricio Perez

Projekt - Dokumentation

Präsentation - https://hackmd.io/@oleg/SJJ_V0nVh#/

Projektteam

Isabelle Bai, Peter Janes, Debora Leuenberger, Simon Hischier, Daniel Oetterli, Christian Peier, Felix Piringer, Bernhard Klöti, Patricio Perez

Vorgehen

- Recherche historische Daten

- Technische Umsetzung

- Erste Idee - Aufbereitung in QGIS, Zusammenführung in Blender, 3D Darstellung in Unity

- Revidierte Idee - gemeinsame Bearbeitung in QGIS, Verzicht auf Blender und Unity aus zeitlichen Gründen

Sichtung Daten

Datensortierung

Grobe Sortierung

Verfeinerte Sortierung

Jahr 1850

Bereinigte Daten

Finale 3D Sicht

Jahr 1900

Ausgangslage

Markierte Daten

Finale 3D Sicht extrudiert

QGIS Modell

Geometrische Verschnitte

Datenselektion

Regular Expressions (Regex) zur Filterung, welche Gebäude heute noch stehen.

Animation

3D Animation

Erkenntnisse

Learnings

- Beim GIS sind nur Grundrisse verfügbar, sowie was für Um- und Ausbau als Freitext im Baugesuch stand. Es ist jedoch nicht direkt erkennbar, wo nur ein Innenausbau vorgenommen wurde oder wo sich die Form des Gebäudes geändert hatte.

- Es ist keine Information zu den Höhen der verschiedenen historischen Gebäuden verfügbar.

- Änderungen an Bauten wurden dokumentiert, jedoch alles als Freitext. Es wird noch eine Kategorisierung benötigt, ob die Änderung einen Einfluss auf die Form des Gebäudes hatte.

- Wenn ein Gebäude umgebaut wurde, ist dies im Shapefile zu den Änderungen nicht ersichtlich. In den Shapefiles ist nie ganz klar, ob ein Gebäude ersetzt oder umgebaut wurde.

Problems & Tools

Zur Datenaufbereitung haben wir die Open Source Software Qgis verwendet. Die Klassifizierung der Layers in «noch vorhanden» und «nicht mehr vorhanden» für die verschiedenen Jahre mussten wir allerdings im arcgis Online verwenden weil wir colaborativ klassifizieren mussten.

Organisation

Ablage

- Google Drive - https://drive.google.com/drive/folders/1p0M_keNbx-WGECHFlpWo8QVTWHh6_JXk

- GitHub (Screen Shots) - https://github.com/TheCell/DataHackDaysBern2023

Weitere Information

DataHackDaysBern2023

Stadtentwicklung in 3D

Wegfall / Bestand

1800

1850

1900

1925

Wegfall / Bestand animiert

Bestand Original

Bestand Extrusion

Bestand Combined

Support – next level!

https://youtu.be/_63omloWUsY?t=2193

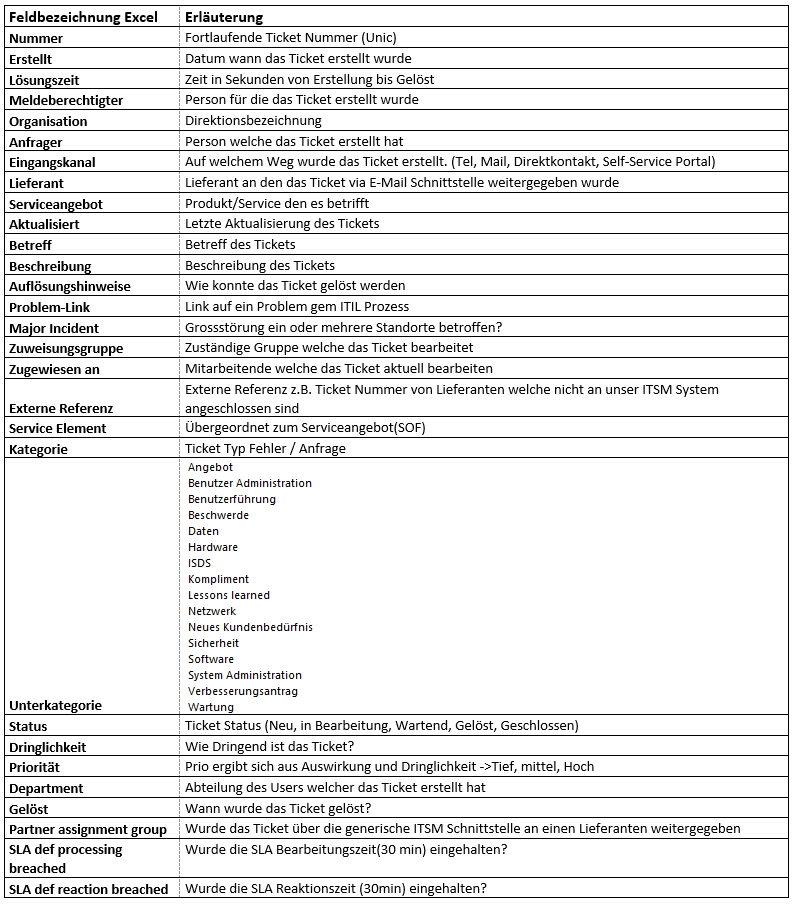

Challenge Slides (PDF)

Das Excel mit den Rohdaten wird an die Challenge-Teilnehmer vor Ort ausgehändigt. Die Daten sind vertraulich zu behandeln und dürfen nicht weitergegeben oder ins Internet hochgeladen werden.

Erwartungen

- Resultierend aus den Daten können jegliche Erkenntnisse für den Support von Bedeutung sein.

- Resultate und Interpretation der Analysen

- Prognosemöglichkeiten über die Häufigkeit, den betroffenen Service und die Herkunft künftiger Tickets.

- Ansätze zur Vertiefung dieser Form von Analyse in der Praxis.

- Mögliche Optimierungen unsere Support-Organisation.

Fazit aus dem Projekt

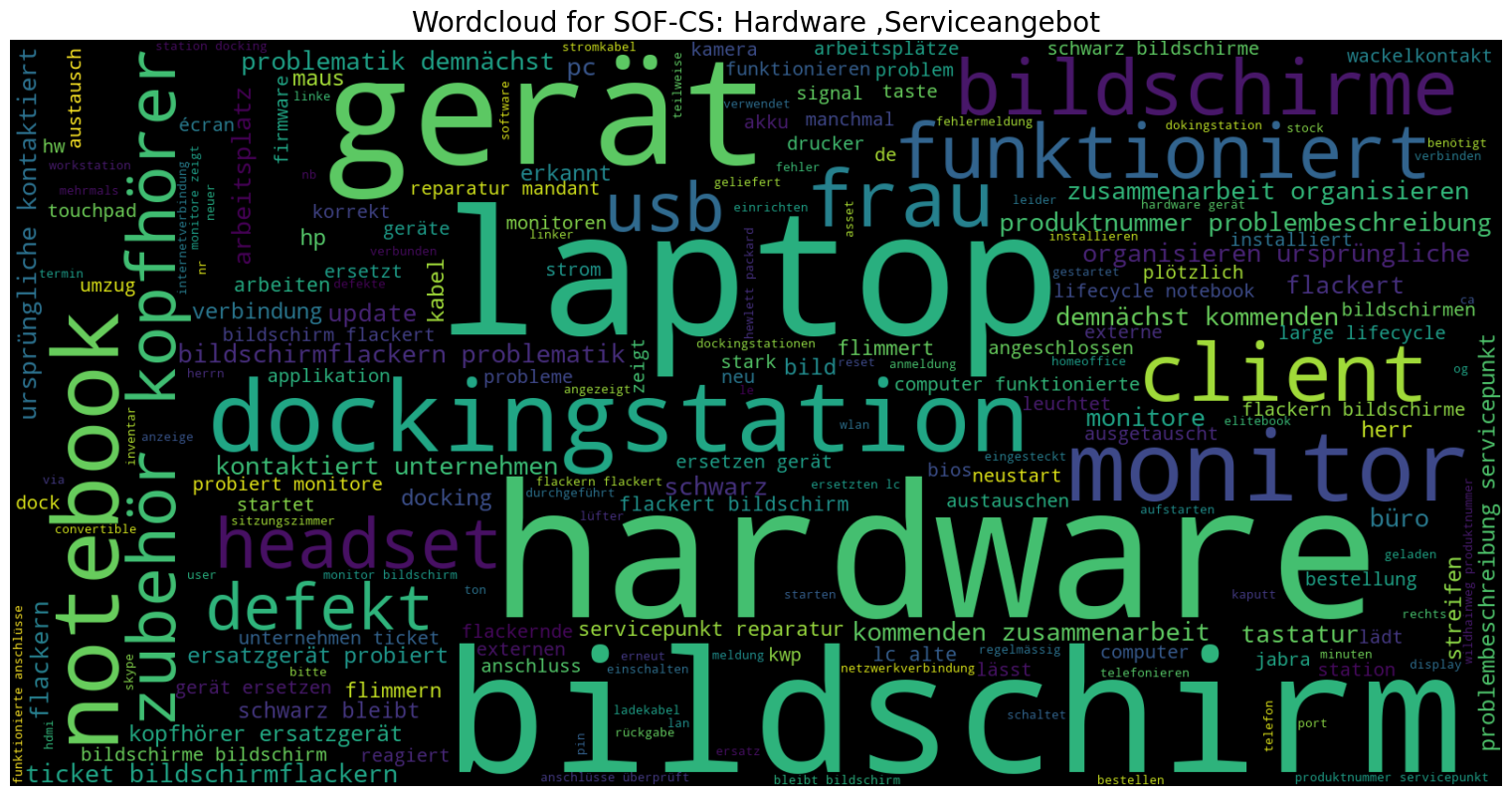

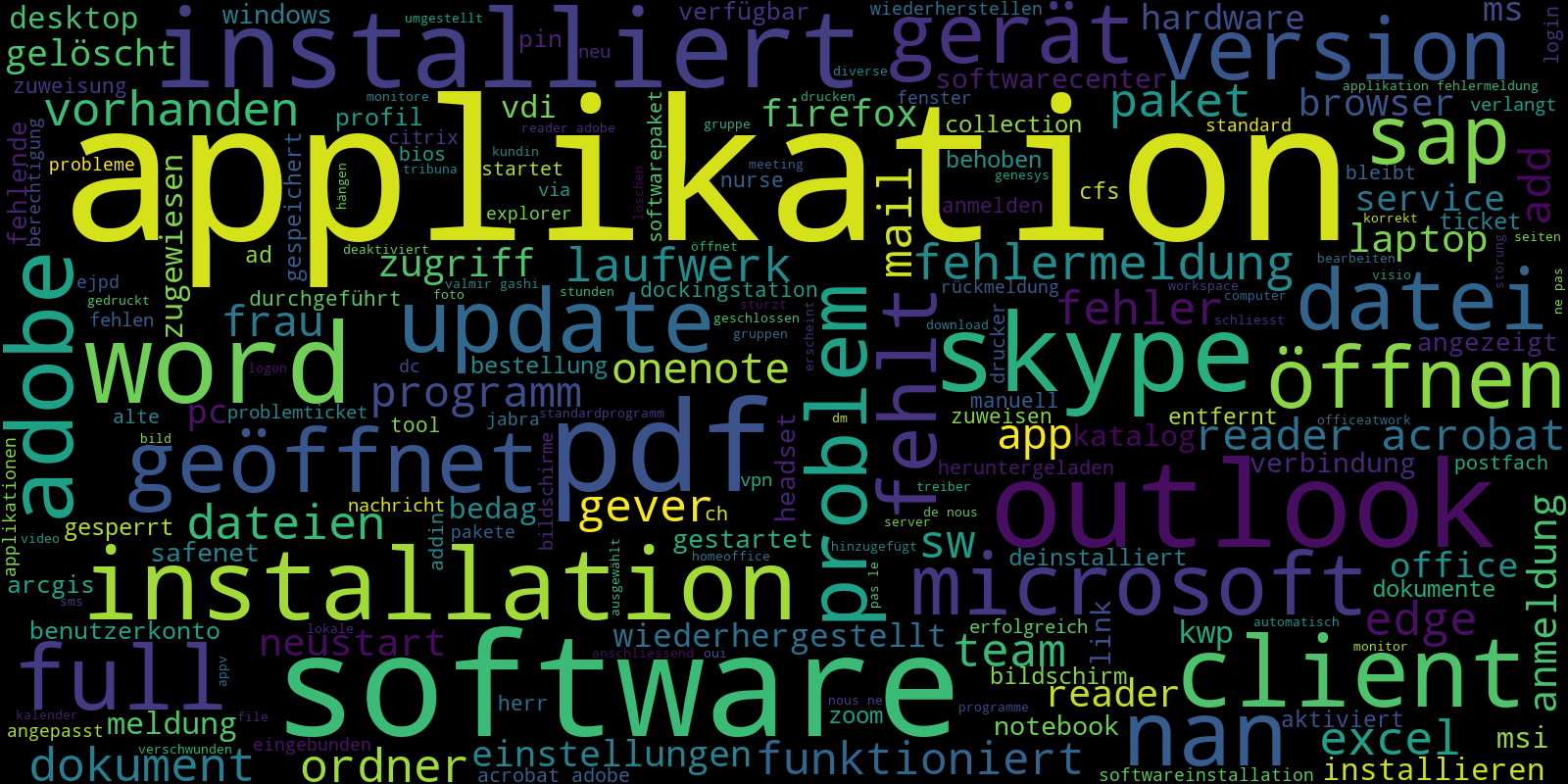

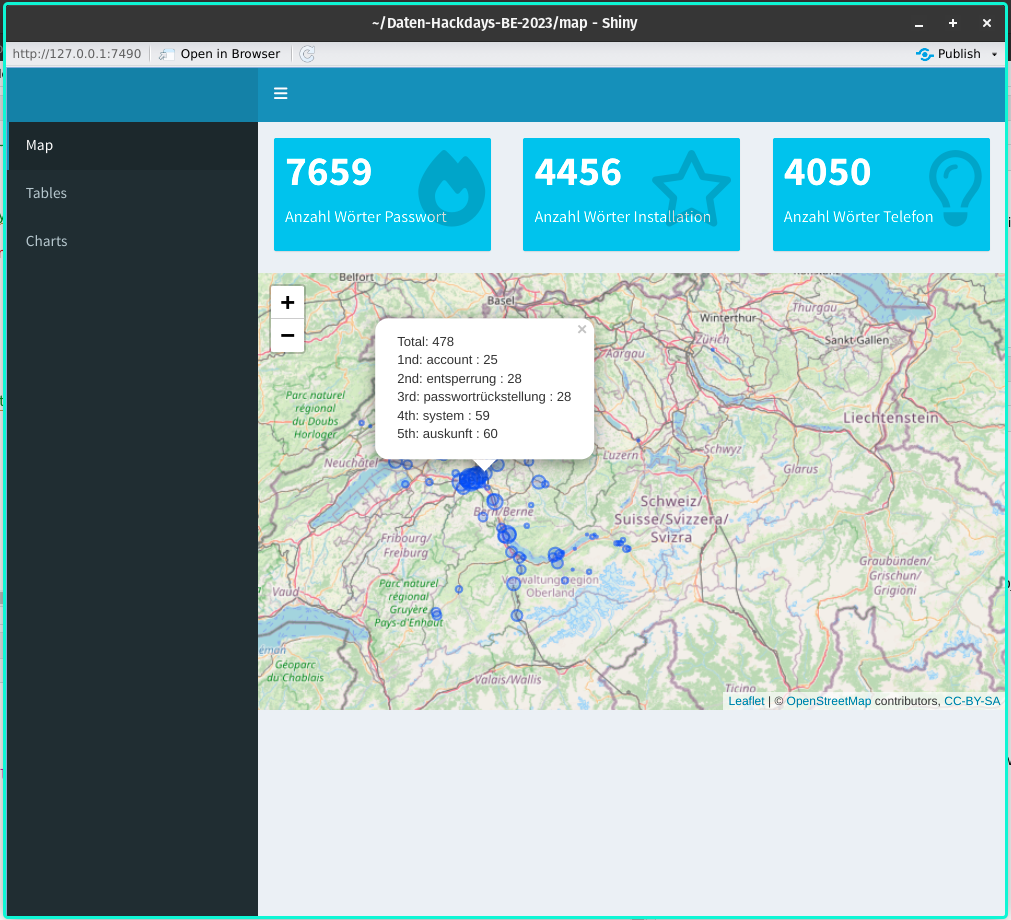

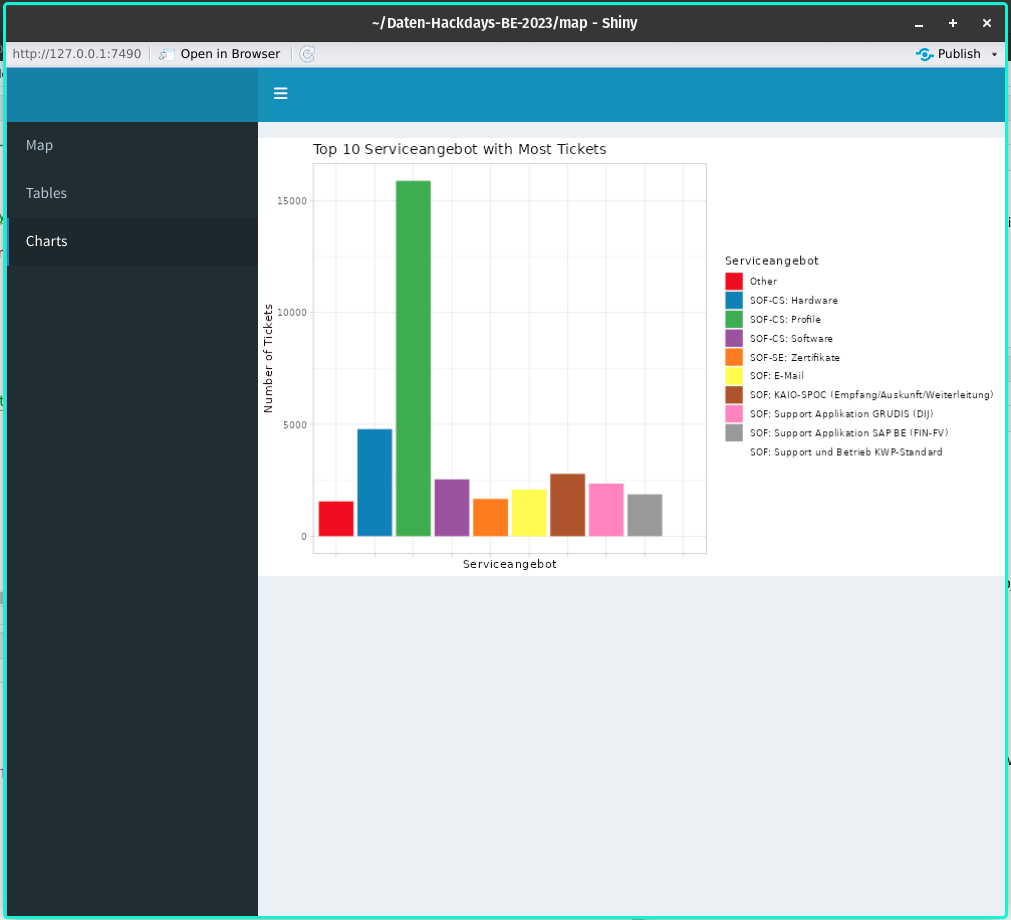

- Wir können pro Standort die wichtigsten Wörter pro Services (einstellbar) anzeigen lassen.

- Der Datensatz wurde komplett analysiert und Wordclouds auf die Service bezogen generiert.

- Der Prototyp ist erstellt (und kann angepasst werden). → Dashboard

- Rein anhand einer Textanalyse, ist das Ermitteln von gleichen Fehlern nicht möglich, es kann höchstens eine Vermutung gemacht werden.

- Mögliche Lösungen erweitern der Tickets durch eine Drittklassifizierung. (Alternative wäre auch die Klassifizierung durch ein LM eine Möglichkeit gewesen)

Wordcloud

Video zu unserem APP

Shiny APP

Weiteres Vorgehen

- Pipeline optimieren: Es dauert zu lange,

- Paralelisierung möglich?

- Dashboard verbessern und ausbauen

- Periodisch Daten erfassen und direkt analysieren

YouTube Link (geht nicht)

Support – next level! 1 –

Was? Service Desk KAIO (1/2) Der Service Desk KAIO ist der Single Point of Contact (SPoC) und agiert als First Level Support für die gesamte Kantonale Verwaltung bei technischen Störungen oder Anfragen zu ICT-Mittel. Nebst der ICT-Grundversorgung werden rund 1’300 verschiedene Services betreut.

Als Drehscheibe zwischen Endbenutzern und den weiteren Support Levels (2nd und 3rd Level) werden Jährlich 70’000 Störungsmeldungen und Anfragen bearbeitet.

2

Was? Kennzahlen First Level Support (2/2) 3 Der First Level Support erfasst die jeweiligen Anfragen und Störungen im IT Service Management System (ITSMS) als Ticket und weist diese einem der 1’300 Services zu. Kennzahlen 2022 Anz.

Requested Items (RITM) 36’062 Incidents (Fehler) 19’757 Incidents (Anfragen) 47’459 Major Incidents 47 Problems 42 Betreute User am 31.12.2022 14’805

Warum? «Wir sehen vor lauter Bäumen den Wald nicht» Wir haben eine Grosszahl an Ticketdaten die aktuell nur bedingt, zu Reporting-Zwecke genutzt werden.

Wer hat etwas davon? Alle involvierte Personen in der Support-Kette. (Bsp. Muster erkennen, Früherkennung etc.) Alle User der Direktionen des Kantons Bern welche durch einen Fehler an der Arbeit gehindert werden.

- August 2022 Data Hackdays BE 2023 - Challenge-Owner-WS 1 4

Ressourcen und Hilfsmittel Die Rohdaten liegen als Excel, CSV oder JSON File vor.

5

Erwartungen (1/2) Resultierend aus den Daten können jegliche Erkenntnisse für den Support von Bedeutung sein. Beispielsweise: Welche Ticket Hotspots gibt es (Geo-Heatmap) Identifizierung der 10 häufigsten Fehler Identifizierung der 10 häufigsten Anfragen Welche Tickets haben die längste Durchlaufzeit Welche Tickets haben die kürzeste Durchlaufzeit Welche Tickets können durch den First Level gelöst werden Populationsspezifische Auffälligkeiten Koinzidenzen zwischen mehreren Dimensionen

6

Erwartungen (2/2) Was sollte am Ende der Hackdays vorliegen? Resultate und Interpretation der Analysen Prognosemöglichkeiten über die Häufigkeit, den betroffenen Service und die Herkunft künftiger Tickets. Ansätze zur Vertiefung dieser Form von Analyse in der Praxis. Mögliche Optimierungen unsere Support Organisation.

7

Ausblick Wie könnte es nach den Hackdays weitergehen? Die erarbeiteten Resultate können nachhaltig im Support genutzt werden, um die Service Levels längerfristig zu verbessern. Weiterführende Zusammenarbeit.

8

Challenge Owner Silvio Burgermeister Fachbereichsleiter Service Desk, Amt für Informatik und Organisation

Team BearingPoint - Nicht versiegelte Flächen

📎 BearingPoint Präsentation Data Hackdays 13.pdf

Linkedin Michael Wehrli: https://www.linkedin.com/in/michael-wehrli/

data_hackdays

Description

Setup

Cloning Repository in ML Studio

git config --global user.name 'your username here'

git config --global user.email 'your email here'

Generate an ssh key:

ssh-keygen -t ed25519 -C "your_email@example.com"

Save the key in your home directory.

Use the following command to see your public ssh key:

cat ~/.ssh/id_ed25519.pub

In your github page, go to settings > SSH and GPG Keys Here add your ssh key that you copied to the clipboad in the step prior. Type yes (the whole word) and press enter and you are done

Test you ssh connection by using this command:

ssh -T git@github.com

Conda Environment Setup

To setup the conda environment, run the following command:

$ create_conda_env.sh

Use the following command to activate the created conda environment:

$ conda activate vision

Visual Studio Code

Visual Studio Code allows to edit and run files on Azure.

Add your own debugging configuration to the launch.json file.

example:

"configurations": [

{

"name": "FlosConfig",

"type": "python",

"request": "launch",

"program": "${file}",

"console": "integratedTerminal",

"python": "/anaconda/envs/vision/bin/python",

"cwd": "~/cloudfiles/code/Users/florian.sonderegger/data_hackdays",

"justMyCode": true

}

]

Team bbv - Nicht versiegelte Flächen

Wir haben mit diesem Hack versucht, nicht versiegelte Flächen in der Stadt Bern durch Satellitenbilder zu lokalisieren.

Nicht versiegelte Flächen erkennen

Wir haben mit diesem Hack versucht, nicht versiegelte Flächen in der Stadt Bern durch Satellitenbilder zu lokalisieren. Diese Flächen sind von Bedeutung, da sie im Sommer das Stadtklima kühlen. Daher sollten sie bestimmt werden, um einen Überblick über das Verhältnis zwischen versiegelten und unversiegelten Flächen zu erhalten.

Zu diesem Zweck haben wir Daten gelabelt, prozesiert und ein neuronales Netz (genauer U-Net) verwendet, um die Bilder zu segmentieren.

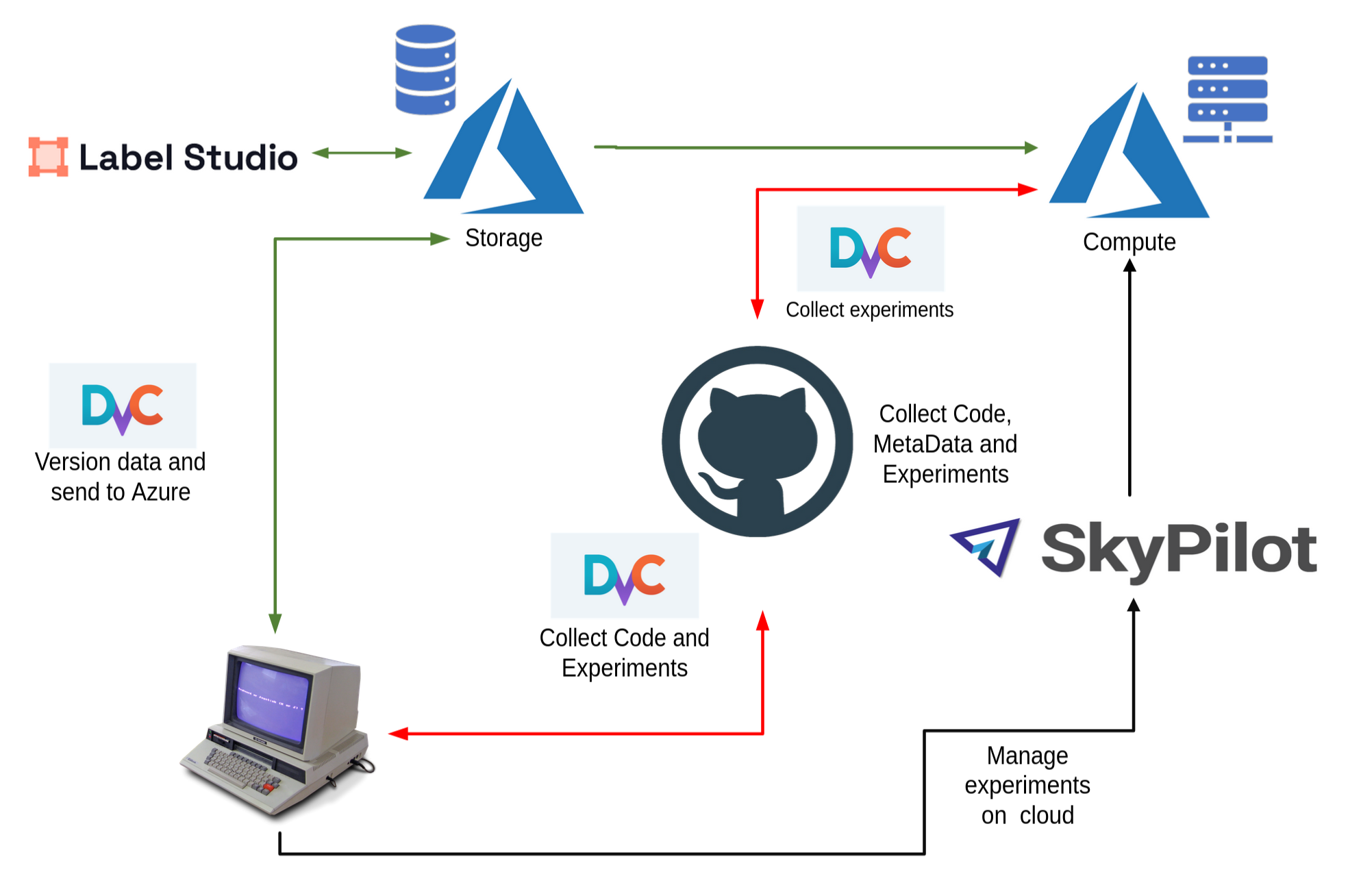

Tools und Zusammenspiel

- Git, zur Versionierung von Code, Configurationen und Metadaten

- DVC, zur Versionierung der Daten und zur Kommunikation mit dem Azure Cloud Storage

- Skypilot, zur einfachen Ausführen von Berechnung in der Cloud

- Azure Cloud, zur Bereitstellung von Speicher und Rechenresourcen

- Label Studio, zum Labeln von Daten

Resultate

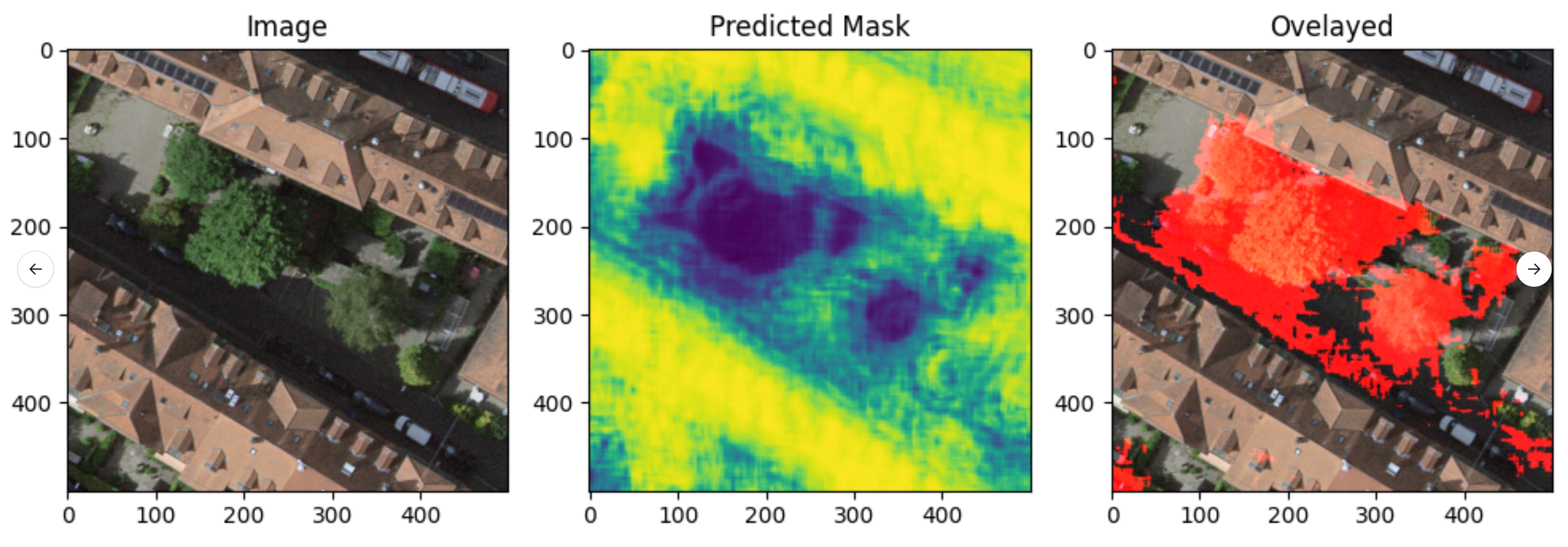

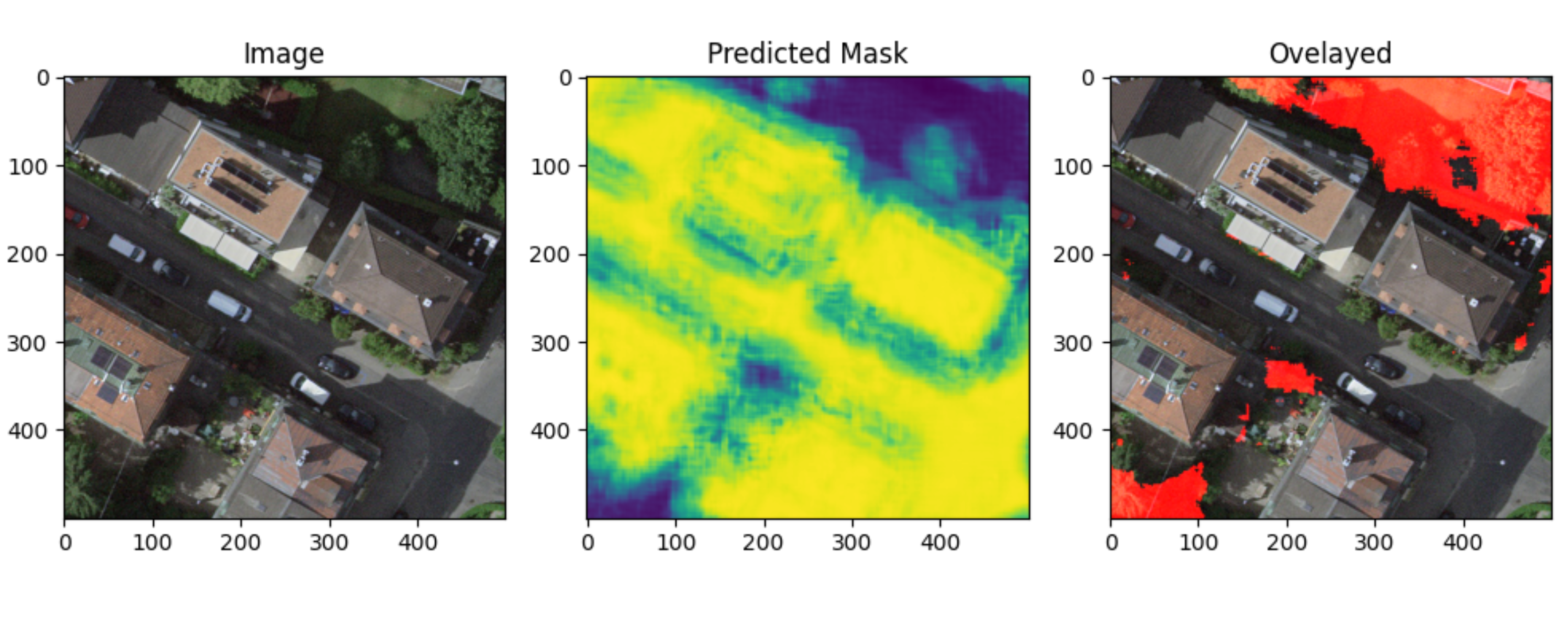

Hier einige der Resultate, links das ursprüngliche Satellitenbild, mittig die sogenannte Maske und rechts das Overlay. In der Maske wird jedem Pixel eine Wahrscheinlichkeit von 0-100% zugeordnet, ob es sich um eine versiegelte Fläche handelt. Für das Overlay wird dann ein Grenzwert bestimmt, über dem wir sagen ein Pixel ist unversiegelt.

Code

https://github.com/bbvch/hackathon_bern_23